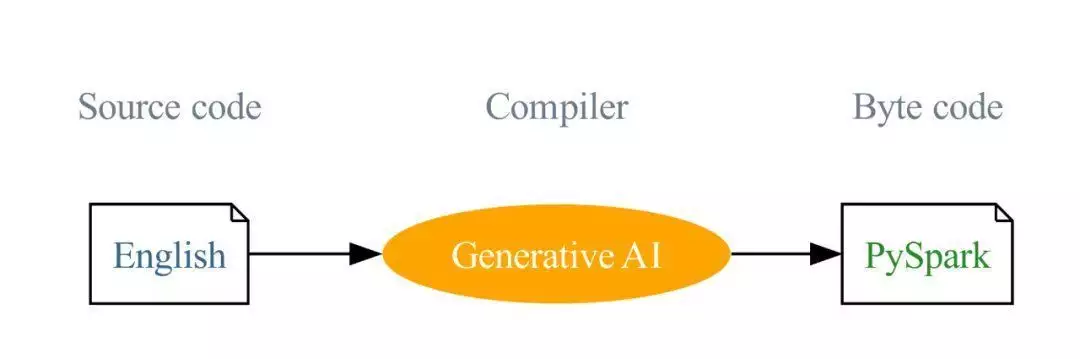

English SDK for Spark : 将英文做为一类捷伊C语言,将聚合式 AI 当作C++, 将 Python 视为二进制码!

责任编辑主要如是说了 Apache Spark 的英文软件设计组件(SDK)的必要性和最终目标,和它选用聚合式 AI 控制技术来多样Spark 的采用新体验。它还提及了GitHubCopilot 对 AI 远距标识符合作开发的负面影响,和其存有的管制和问题。责任编辑还绍了英文 SDK 的特

书名镜像:https://www.databricks.com/blog/introducing-english-new-programming-language-apache-spark

需经容许,明令禁止转发!

译者 | Gengliang Wang,Xiangrui Meng,Reynold Xin,Allison Wang,Amanda Liu和Denny Lee 翻译者 | 没错如月 白眉林 | 夏萌公司出品 | CSDN(ID:CSDNnews)前言

他们十分兴奋向我们如是说 Apache Spark 的英文软件设计组件(SDK)。这是一个颠覆性的辅助工具,意在多样你的 Spark 采用新体验。Apache Spark™ 在亚洲沿海地区范围内,全面覆盖 208 个国家和沿海地区,年使用者数少于 10 万次,已经在小规模数据挖掘应用领域获得了巨大成就。他们的英文 SDK 选用一流的聚合型 AI 控制技术,意在不断扩大这个活耀的街道社区,使 Spark 在可用性通好Branne上达至空前的度!

共相

GitHub Copilot 对 AI 远距的标识符合作开发应用领域造成了不可估量的负面影响。尽管它采用方便,但使用者须要认知聚合的标识符后就可以递交。同时,审核者也须要认知标识符就可以进行审核。这可能会管制其应用的两大妨碍。当处理 Spark 表和 DataFrames 时,它偶尔也会聚合不正确或不符合预期的标识符。下面的 GIF 动图展示了这一点,Copilot 提出了一个窗口规范,并引用了不存有的dept_id列,这须要一些专业知识就可以认知。

广告与其将 AI 视为副驾驶,为何不让 AI 当作司机,他们坐在豪华的后座享受呢?这就是他们英文 SDK 所要扮演的角色。他们发现,尖端的大型语言模型对 Spark 十分了解,这得益于优秀的 Spark 街道社区,他们在过去十年中,贡献了大量的开放的、高质量的内容,比如 API 文档、开源项目、问题和答案、教程和书籍等。现在,他们将这些聚合型 AI 对 Spark 的专业知识融入到英文 SDK 中。你不再须要认知复杂的聚合标识符,只需用简单的英文指令即可得到结果:

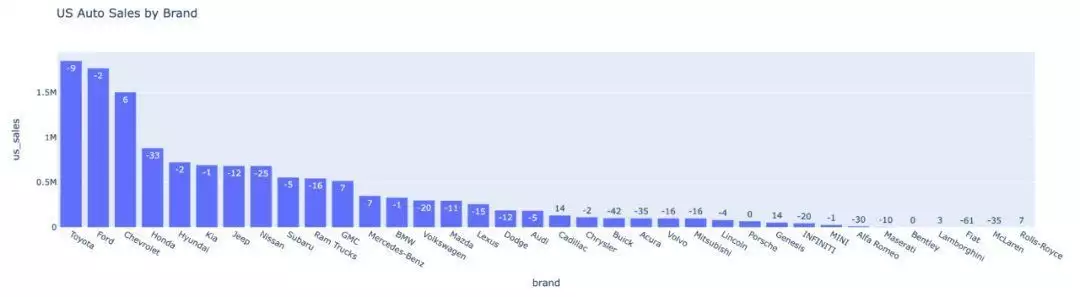

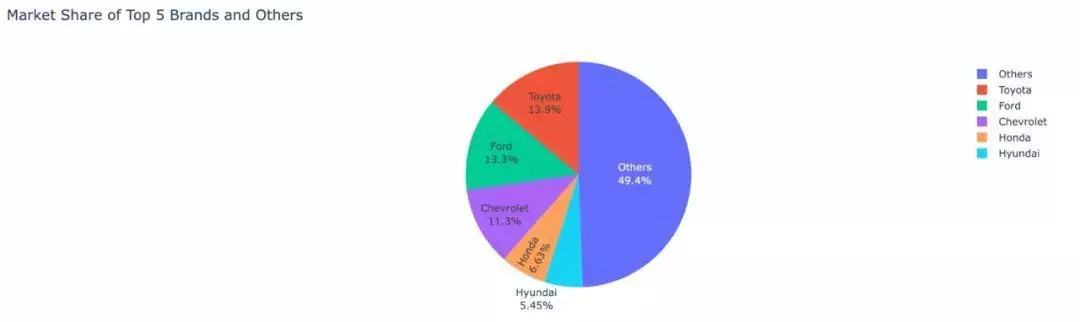

transformed_df = df.ai.transform(get 4 week moving average sales by dept)英文 SDK 通过认知 Spark 表和 DataFrames 来处理复杂性,并直接返回一个正确的 DataFrame !他们的愿景是:将英文做为一类C语言,并采用聚合式 AI 将这些英文指令编译成 PySpark 和 SQL 标识符。这种创捷伊方式意在降低编程的门槛和简化学习曲线。这个愿景是推动英文 SDK 的主要驱动力,他们的最终目标是不断扩大 Spark 的负面影响力,让 Spark 从一个成功走向另一个成功。 英文 SDK 的特性英文 SDK 通过实现以下关键特性,使 Spark 的合作开发过程变得更简单::根据你的描述,SDK 可以进行网络搜索,运用大型语言模型 (LLM) 确定最佳结果,然后顺利地将选定的网络数据集成到 Spark 中,这些操作都能在一个步骤中完成。DataFrame 操作:SDK 对指定的 DataFrame 提供了功能,根据你的英文描述执行转换、绘图和解释操作。这些功能大大提升了标识符的可读性和效率,使得对 DataFrames 的操作更加直接和直观。自定义函数 (UDFs):SDK 提供了简洁的创建 UDFs 的流程。你只须要提供一段描述,AI 就可以负责标识符的补全。这一特性简化了 UDF 的创建过程,让你可以专注于函数定义,而 AI 则会处理其余部分。缓存:SDK 吸取了缓存的优点以提升执行速度,保证结果的可复用性,并节省成本。示例为了进一步说明如何采用英文 SDK,他们将通过一些例子进行演示:如果你是一名数据科学家,须要导入2022年美国全国汽车销售数据,您只须要两行标识符即可完成:spark_ai = SparkAI()auto_df = spark_ai.create_df(“2022 USA national auto sales by brand”)DataFrame 操作 对于给定的 DataFrame 对象,SDK 容许你运行以 df.ai 开头的方法。这包括转换、绘图、DataFrame 解释等等。要激活 PySpark DataFrame 的部分函数:spark_ai.activate()要预览 auto_df:auto_df.ai.plot() 广告