原副标题:AI伺服器生产成本预测 英伟达狂热行骗

为人工智慧体能训练和逻辑推理建立互联网系统的风潮早已导致消费市场狂热。例如,Credo上周下跌了 27%。Vicor 下跌了 30%,除了很多其它子公司与 Nvidia 并驾齐驱,但在本栏看来,她们都不值得今天的受惠,而且另一方面,很多子公司没有得到她们所获的适当荣誉奖。

IT 财政预算有限。它可能会有所提升,但有鉴于宏观经济的不稳定性,大多数企业的资本开支和营运开支最有可能必须保持固定。因而,Nvidia 产品销售的主要经济繁荣直接来自购买极少的非 GPU 伺服器。消费市场早已认识到,由于 AI 开支的转移,现代 CPU 的产品销售将会疲弱。Nvidia 在今年剩余时间的互联网系统收入高于英特尔互联网系统,这清楚地证明了这一点。

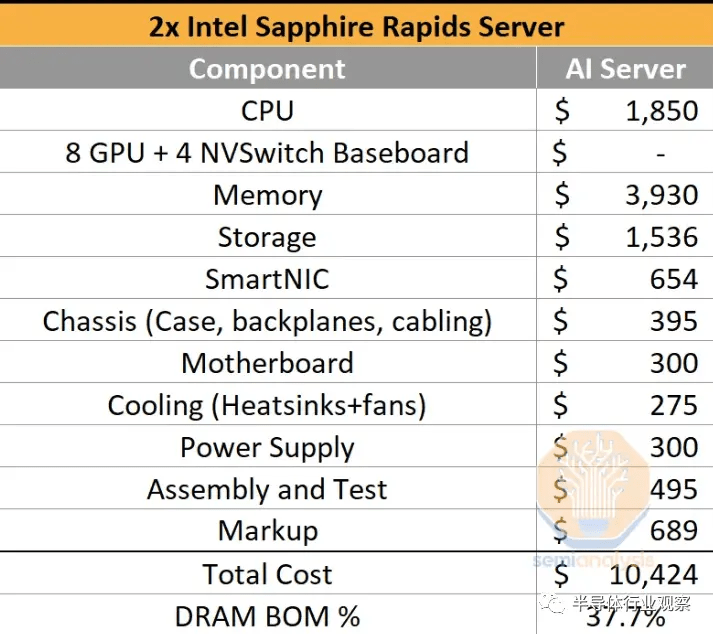

以内是仅标准 CPU 伺服器的普通高中生产成本备注。典型的 CPU 伺服器差别很大,因而请亦须认识到这只是她们认为高效能但大容量的阻抗。对大批持有者而言,总生产成本约为 10,424 英镑,其中主要包括原初设备生产商的约 700 英镑利润。缓存几乎占伺服器生产成本的 40%,每个连接埠 512GB,共计 1TB。伺服器周围除了其它一些缓存,主要包括储存设备、BMC、管理储存设备等,但那些对 DRAM 端总生产成本来说是显而易见的。她们确实将那些模块包涵在每边共享资源的 BOM 生产成本中。

NAND占总BOM的14.7%。众所周知,很多人早已转为互联网储存,所以那个位数比更现代的构架应该有的是位数要高得多,但这更多是因为其它伺服器有大批的 NAND 和很少的其它东西。缓存作为一个整体的生产成本是现代伺服器布署生产成本的一半以内。值得一提,在那个生产当期中,她们忽视了互联网。

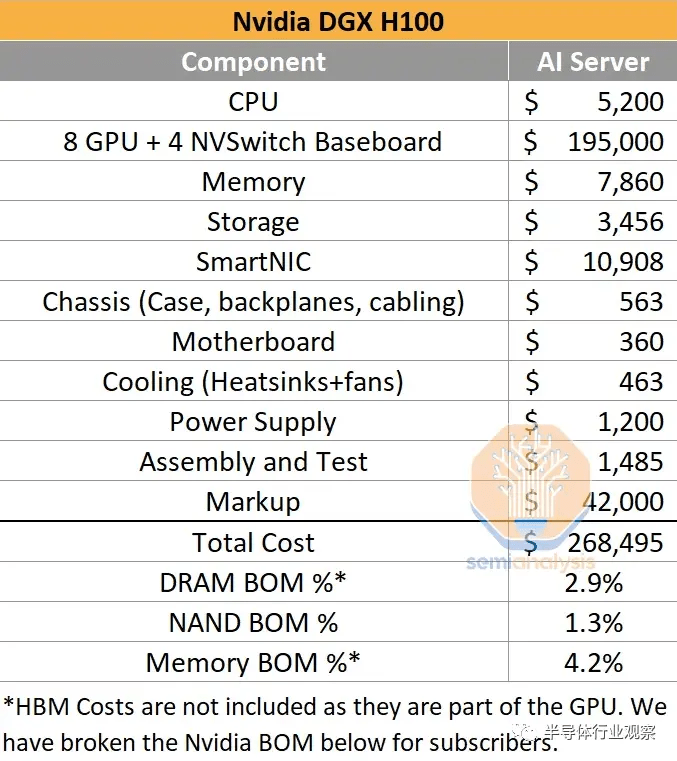

总体而言,虽然仍然会有很多普通服务器,但随著人工智慧时代的到来,它的比例会降低。单位伺服器的比率将低得多,但以英镑排序,差别是巨大的。随著互联网系统转为加速排序,分配给各种模块的生产成本发生了巨变。Nvidia 的 DGX H100 单价约为 270,000 英镑。下面的生产成本备注主要包括 Nvidia 在 GPU + Switch 硅片和整个 DGX 伺服器上的记号。

另外,她们除了一个 8 GPU + 4 NVSwitch 硅片 BOM 生产成本备注,主要包括供电系统、缓存、装配、加热、GPU 生产成本、CoWoS 生产成本、裸片生产成本、良率生产成本、HBM 生产成本等。

Nvidia 每台 DGX H100 的毛利润接近 190,000 英镑。当然,研发和其它营运费用会降低很多。无论如何,尽管每台伺服器的 DDR5 缓存增长到 2TB,但这种巨大的利润率伴随著缓存生产成本占伺服器比率的巨变。前端互联网中还会有其它基于 CPU 和储存的伺服器,但在排除 HBM 时,AI 伺服器本身分配给缓存的总生产成本不到 5%。

HBM 生产成本显然非常重要,特别是考虑到 Nvidia 目前正在单一采购其所有 HBM3。她们在下面为订户分担那些费用。

GPU一卡难求,专家:至少等六个月!

谷歌首席执行官将人工智慧革命比作人类对火的驾驭. 现在,要是那个行业能够确保位数引火物为其提供燃料就好了。

作为新一代人工智慧系统生命线的先进芯片的短缺引发了一场锁定排序能力和寻找解决方法的竞赛。用于 AI 的图形芯片或 GPU 几乎全部由制造。但随著ChatGPT 的病毒式成功,对它的需求激增远远超过了供应,ChatGPT 是一种能够以类似人类的方式回答问题的聊天机器人。

“因为存在短缺,这与你认识的人有关,”Lamini 的联合创始人兼首席执行官 Sharon Zhou 说,Lamini 是一家帮助子公司构建人工智慧模型(如聊天机器人)的初创子公司。“这就像大流行期间的卫生纸。”

亚马逊网站和等云服务提供商微软可以向 ChatGPT 背后的子公司 OpenAI 等客户提供的处理能力。AI 开发人员需要伺服器容量来开发和操作她们日益复杂的模型,并帮助其它子公司构建 AI 服务。

即使是世界上联系最紧密的科技企业家也在努力确保产能。在 5 月 16 日关于 AI 的国会听证会上,OpenAI 首席执行官Sam Altman表示,由于处理器瓶颈,如果使用 ChatGPT 的人少一些会更好。

“在这一点上,GPU 比药物更难获得,” Elon Musk在 5 月 23 日告诉华尔街日报CEO 委员会峰会。

不过,成为马斯克有其好处。知情人士称,今年早些时候,急需甲骨文排序能力的初创子公司突然被告知买家抢购了甲骨文的大部分备用伺服器空间。知情人士说,初创子公司被告知买家是马斯克,他正在打造自己的 OpenAI 竞争对手 X.AI。

获得数以万计的高级图形芯片对培训可以生成原初文本和预测的大型 AI 模型的子公司来说至关重要。创始人说,如果没有它,人工智慧背后的大型语言模型的工作就会运行得慢得多。Nvidia 的高级图形芯片擅长同时进行大批排序,这对 AI 工作至关重要。

瑞银预测师估计,较早版本的 ChatGPT 需要大约 10,000 个图形芯片。马斯克估计更新版本需要 Nvidia 先进处理器的三到五倍。

一些投资者正在梳理她们的互联网以获得备用排序能力,而另一些投资者则在协调处理器和伺服器容量的批量订单,那些处理器和伺服器容量可以在她们的 AI 初创子公司之间共享资源。据 AI 投资者和初创子公司称,初创子公司正在缩小她们的 AI 模型以提高效率,她们购买自己的带有相关图形芯片的物理服务器,或者转而使用甲骨文等不太受欢迎的云提供商,直到短缺问题得到解决。

其它创始人只是乞求亚马逊和微软的产品销售人员获得更多权力。

周说,她与一位前 Nvidia 工程师共同创立的 Lamini 拥有所需的芯片。她和接受《华尔街日报》采访的很多其它创始人拒绝确切说明她们是如何获得那些资产的。

“业界对 GPU 的需求强劲,”OpenAI 发言人表示,并补充说该子公司致力于确保其客户拥有所需的容量。

甲骨文和马斯克没有回应置评请求。微软和亚马逊拒绝置评。

Nvidia 最近表示,它正在扩大供应以满足不断增长的需求,但很多 AI 创始人预计短缺至少会持续到明年。对 Nvidia 产品的需求推动该子公司股价下跌约 167%。芯片生产成本各不相同,但一些零售商以约 33,000 英镑的价格出售 Nvidia 的高级 AI 芯片,尽管在需求旺盛的情况下它可以在二级消费市场上获得更高的价格。

一些子公司正在封锁云容量,因为担心她们以后无法访问它。“人们现在只是继续为它付费,即使她们不需要它,”Arthur 的首席执行官 Adam Wenchel 说,该子公司开发工具来保护子公司免受数据泄露等 AI 风险的影响。

创始人和投资者表示,能够获得排序能力的子公司仍需等待数周才能使用它。Perplexity AI 的首席执行官 Aravind Srinivas 说:“即使你早已预付了费用,也不意味着 GPU 会在第二天或一周内送到你这里来。”该子公司构建了一个人工智慧驱动的对话搜索工具。“你只需要等待。”

伺服器生产商及其直接客户表示,她们需要等待六个月以内才能获得 Nvidia 最新的图形芯片。Supermicro的首席执行官表示,该子公司的图形芯片系统订单处于历史最高水平,该子公司正急于增加制造能力。

所有那些都为那些先进的芯片创造了二级消费市场,部分涉及大型加密子公司,那些子公司在经济繁荣时期购买芯片进行采矿,而现在在位数货币消费市场低迷的情况下不需要。

AI研究子公司Generally Intelligent的首席执行官邱侃君自去年以来一直在为自己的伺服器购买先进的图形芯片,以渡过当前的短缺。一位风险投资家最近给她发消息,询问她是否有闲置产能可以出租给其它初创子公司。秋还没有决定是否放弃她的芯片。

与此同时,OpenAI 的奥特曼和其它员工一直在处理来自在其平台上构建人工智慧服务的子公司的投诉。

为医生开发人工智慧助手的 Nabla 的首席执行官兼创始人亚历克斯勒布伦表示,OpenAI 的软件可能需要长达两分钟的时间来响应查询。Nabla 使用 AI 自动生成笔记、推荐信和临床建议,其客户希望那些笔记能够立即生成。

Lebrun 说,作为一种解决方法,Nabla 早已构建了一些更简单的模型来更快地生成材料的初稿,然后依靠最新版本的 ChatGPT 进行最终调整。“优秀的初创子公司是那些学会如何解决所有那些限制的子公司,”Lebrun 说,并补充说他直接向 Altman 提出了那些问题。

Altman 和其它 OpenAI 代表告诉创始人,该子公司正在与其最大的投资者和互联网系统提供商微软合作解决那个问题。