该文已经开始前给须要自修的老师提供更多这份nginx非官方英文文件格式,期望能试试他们,上方卡牌直通申领。

已经开始节录!

撷取一则源自DD91的该文,对Nginx的传授十分妥当,该文镜像:精辟Nginx,译者网页:张丰哲 – DD91

。

Nginx是这款轻量的Web伺服器、逆向全权伺服器,虽然它的缓存挤占少,开启十分快,高mammalian潜能强,在网络工程项目中应用。

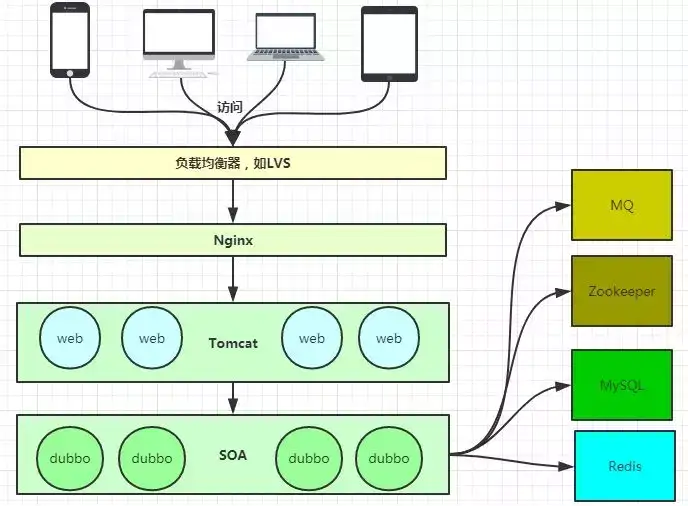

洼瓣上图大体上说明了当今社会盛行的控制技术构架,当中Nginx有点儿出口处交换机的香味。

逆向全权伺服器?

时常听人说到许多名词,如逆向全权,所以甚么是逆向全权,甚么又是萨德基全权呢?

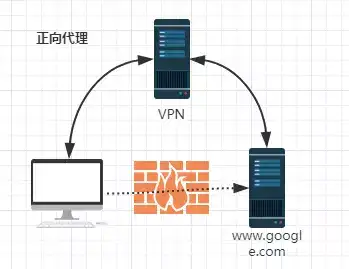

萨德基全权:

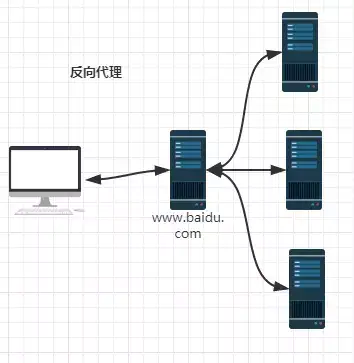

萨德基全权左图逆向全权:

逆向全权左图虽然内网的其原因,他们并无法间接出访Google,所以他们能借助于VPN来同时实现,这是两个单纯的萨德基全权的范例。这儿你能辨认出,萨德基全权“全权”的是应用程序,所以应用程序是知道目标的,而目标是不知道应用程序是通过VPN出访的。

当他们在外网出访百度的时候,其实会进行两个转发,全权到内网去,这是所谓的逆向全权,即逆向全权“全权”的是伺服器端,所以这两个过程对于应用程序而言是透明的。

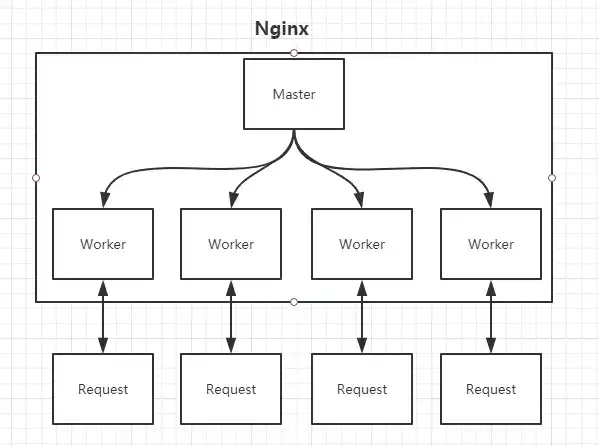

Nginx的Master-Worker模式

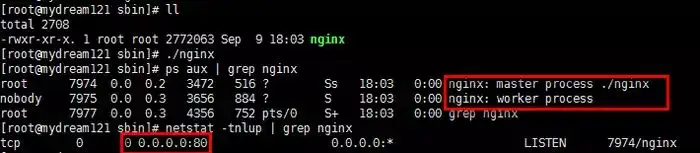

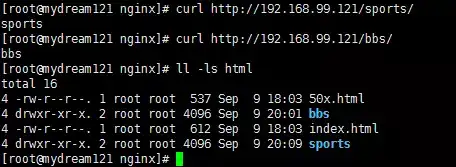

nginx进程开启Nginx后,其实是在80端口开启了Socket服务进行监听,如图所示,Nginx涉及Master进程和Worker进程。

Master-Worker模式nginx.confMaster进程的作用是?

读取并验证配置文件nginx.conf;管理worker进程;

Worker进程的作用是?

每两个Worker进程都维护两个线程(避免线程切换),处理连接和请求;注意Worker进程的个数由配置文件决定,一般和CPU个数相关(有利于进程切换),配置几个就有几个Worker进程。

思考:Nginx如何做到热部署?

所谓热部署,是配置文件nginx.conf修改后,不须要stop Nginx,不须要中断请求,就能让配置文件生效!(nginx -s reload 重新加载/nginx -t检查配置/nginx -s stop)

通过上文他们已经知道worker进程负责处理具体的请求,所以如果想达到热部署的效果,能想象:

方案一:

修改配置文件nginx.conf后,主进程master负责推送给woker进程更新配置信息,woker进程收到信息后,更新进程内部的线程信息。(有点儿valatile的香味)

方案二:

修改配置文件nginx.conf后,重新生成新的worker进程,当然会以新的配置进行处理请求,所以新的请求必须都交给新的worker进程,至于老的worker进程,等把那些以前的请求处理完毕后,kill掉即可。

Nginx采用的是方案二来达到热部署的!

思考:Nginx如何做到高mammalian下的高效处理?

上文已经提及Nginx的worker进程个数与CPU绑定、worker进程内部包含两个线程高效回环处理请求,这的确有助于效率,但这是不够的。

作为专业的程序员,他们能开一下脑洞:BIO/NIO/AIO、异步/同步、阻塞/非阻塞…

要同时处理所以多的请求,要知道,有的请求须要发生IO,可能须要很长时间,如果等着它,就会拖慢worker的处理速度。

Nginx采用了Linux的epoll模型,epoll模型基于事件驱动机制,它能监控多个事件是否准备完毕,如果OK,所以放入epoll队列中,这个过程是异步的。worker只须要从epoll队列循环处理即可。

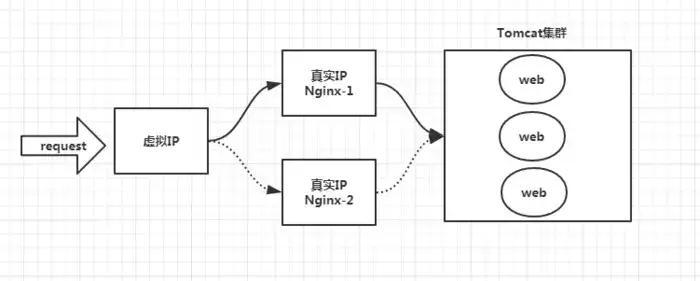

思考:Nginx挂了怎么办?

Nginx既然作为出口处交换机,很重要,如果出现单点问题,显然是不可接受的。

答案是:Keepalived+Nginx同时实现高可用。

Keepalived是两个高可用解决方案,主要是用来防止伺服器单点发生故障,能通过和Nginx配合来同时实现Web服务的高可用。(其实,Keepalived不仅仅能和Nginx配合,还能和很多其他服务配合)

Keepalived+Nginx同时实现高可用的思路:

第一:请求不要间接打到Nginx上,应该先通过Keepalived(这是所谓虚拟IP,VIP)

第二:Keepalived应该能监控Nginx的生命状态(提供更多两个用户自定义的脚本,定期检查Nginx进程状态,进行权重变化,,从而同时实现Nginx故障切换)

Keepalived+Nginx他们的主战场:nginx.conf

很多时候,在开发、测试环境下,他们都得自己去配置Nginx,是去配置nginx.conf。

nginx.conf是典型的分段配置文件,下面他们来分析下。

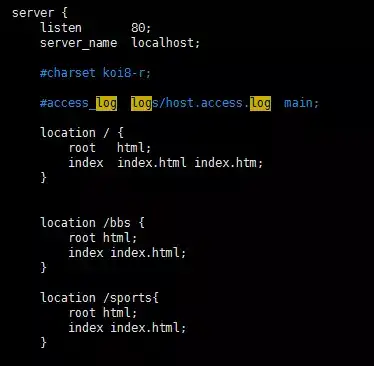

虚拟主机

http的server段出访结果其实这是把Nginx作为web server来处理静态资源。

第一:location能进行正则匹配,应该注意正则的几种形式以及优先级。(这儿不展开)

第二:Nginx能提高速度的当中两个特性是:动静分离,是把静态资源放到Nginx上,由Nginx管理,动态请求转发给后端。

第三:他们能在Nginx下把静态资源、日志文件归属到不同域名下(也即是目录),这样方便管理维护。

第四:Nginx能进行IP出访控制,有些电商平台,就能在Nginx这一层,做一下处理,内置两个黑名单模块,所以就不必等请求通过Nginx达到后端在进行拦截,而是间接在Nginx这一层就处理掉。

逆向全权【proxy_pass】

所谓逆向全权,很单纯,其实是在location这一段配置中的root替换成proxy_pass即可。root说明是静态资源,能由Nginx进行返回;而proxy_pass说明是动态请求,须要进行转发,比如全权到Tomcat上。

逆向全权,上面已经说了,过程是透明的,比如说request -> Nginx -> Tomcat,所以对于Tomcat而言,请求的IP地址是Nginx的地址,而非真实的request地址,这一点须要注意。不过好在Nginx不仅仅能逆向全权请求,还能由用户自定义设置HTTP HEADER。

负载均衡【upstream】

上面的逆向全权中,他们通过proxy_pass来指定Tomcat的地址,很显然他们只能指定一台Tomcat地址,所以他们如果想指定多台来达到负载均衡呢?

第一,通过upstream来定义一组Tomcat,并指定负载策略(IPHASH、加权论调、最少连接),健康检查策略(Nginx能监控这一组Tomcat的状态)等。

第二,将proxy_pass替换成upstream指定的值即可。

负载均衡可能带来的问题?

负载均衡所带来的明显的问题是,两个请求,能到A server,也能到B server,这完全不受他们的控制,当然这也不是甚么问题,只是他们得注意的是:用户状态的保存问题,如Session会话信息,无法在保存到伺服器上。

缓存

缓存,是Nginx提供更多的,能加快出访速度的机制,说白了,在配置上是两个开启,同时指定目录,让缓存能存储到磁盘上。具体配置,他们能参考Nginx非官方文件格式,这儿就不在展开了。

最近看到许多相关该文,比较详细。想深入了解能看看。

你想更深入了解自修Linux知识体系,你能看一下他们花费了两个多月整理了上百小时的几百个知识点体系内容:

往期精彩该文,欢迎点赞收藏!