AIGC已经开始改变世界,自从 ChatGPT 谈话机器的陨落后,occasion,人工智慧也已经开始从交互理解走向生成创造,这是一个关键里程碑式。ChatGPT上架后很快风靡一时,短短的4个月时间里,国内至少30个研制政府机构与企业纷纷推出自有品牌的大数学模型与相关产品。生成式AI大数学模型完成了从0到1的脱胎换骨,是科技革命产业发展到特定历史阶段的产物,因此已正式成为今后产业行业发展趋势,推动AI迈入通用人工智慧。

然而,特斯拉却公开表示ChatGPT“好得可怕”(scary good),危险的强人工智慧或许已离不他们不远。去年4月,特斯拉、《人类百科辞典》作者Yuval Noah Harari、耶鲁大学副教授丹尼尔等1000数名人工智能专家和行业元老在联名信中敦促:“ChatGPT等AI研究所需中止研制6个月!”给出的理由是“只有当他们坚信它的影响是积极的,因此它的信用风险是受控的这时候,才能开发更强大的人工智慧系统。”

得力于,大数学模型飞速产业发展的同时也面临着诸多信用风险窘境,统计数据个人隐私外泄、恶意软件、统计数据误用、统计数据垄断、波镇、迪雷省统计数据即将用尽等早已正式成为大数学模型的主要“安全隐患”。香港中文大学专题讲座副教授、澳大利亚美国科学院及澳大利亚三一学院参众两院院士赵辛楣及其团队已经开始试著透过联邦政府自学和大数学模型紧密结合的形式,重构大数学模型下的统计数据自然生态与安全可靠之困。

分散的小数学模型协同,或将重构大数学模型产业发展之困

4月18日,OpenAI CEO Sam Altman在讨论大数学模型产业发展的趋势的这时候指出,让数学模型显得更大将不会进一步带来重大进展。他说,“我指出他们正处于将数学模型做大这一时代的十字路口。他们将以其他形式使它显得更好。”今后数学模型参数应该向更小的方向产业发展,或者以数个小数学模型协同的形式工作。

“让大数学模型变大”已经正式成为众多人类学家非常钟爱的一条路,大家先后做了很多试著,果不其然 Meta 开放源码了 LLaMA,让学术界和小公司可以体能训练自己的数学模型。随后史丹福人类学家启动了 Lamini,为每个开发者提供了从 GPT-3 到 ChatGPT 的快速Listary计划。

去年4月,个人隐私计算联邦政府自学开放源码平台FATE(Federated AI Technology Enabler)正式发布联邦政府大数学模型FATE-LLM模块,同样是“小数学模型协同”的思路,FATE-LLM则是透过将联邦政府自学和大数学模型紧密结合,在各合作方的敏感统计数据不出本地域性的前提下,根据各方实际统计信息量展开INS13ZD投入,联合展开大数学模型体能训练。

基于此技术计划,数个政府机构可以透过FATE内建的预体能训练数学模型展开横向联邦政府,利用各自个人隐私统计数据展开联邦政府大数学模型微调,从而提升自身大数学模型应用的效果。联邦政府大数学模型不仅主要解决的是大数学模型体能训练阶段的个人隐私保护问题,今后还将研究在使用大数学模型的过程中如何保护用户的个人隐私。

这种用小数学模型联动大数学模型的形式,也很好地诠释了小数学模型协同的精髓。联邦政府自学作为一种分布式机器自学新范式,其“统计数据不动数学模型动,统计数据可用不可见”的特点有助于各合作方在保护各自统计数据安全可靠与用户个人隐私的前提下,展开AI协同,打破统计数据孤岛。

也正是因为联邦政府自学的这一属性,为今后大数学模型的产业发展提供新的思路:联邦政府自学与大数学模型紧密结合,或将有助于构建安全可靠合规的统计数据自然生态大陆。

近期联邦政府大数学模型对现有大数学模型的支持已经在实操层面上有了很多重大进展,FATE开放源码社区TSC Maintainer、开发专委会核心成员范涛表示:“目前的FATE-LLM可以提供对主流大数学模型的支持,4月发布了联邦政府大数学模型FATE-LLM对GPT-2等大数学模型的支持,5月发布了对清华GLM大数学模型的支持。”

联邦政府大数学模型,也需要面对“原生困境”

和大数学模型面临的窘境类似,即便是以大化小,联邦政府大数学模型从根本地解决了大数学模型面临的一些问题,但是联邦政府大数学模型依然有着自己要解决的“原生困境”。

公平性是否能够得到保障?统计数据个人隐私性是否能够有效保护?规模大小不一的异构数学模型集如何统一调配体能训练?这些也给联邦政府大数学模型的人类学家们提出了难题。从2018年开始,赵辛楣副教授和其团队始终致力于于联邦政府自学的研究,如今,面对联邦政府大数学模型可能遇到的技术难题,赵辛楣副教授指出,想要在数个维度实现“既要,又要”(既要安全可靠可信,又要高效可用),那么就必须在“平衡”上做文章。

赵辛楣副教授指出,“今后,人工智慧数学模型一定会正式成为他们贴身的人工智慧助理,这就要求人工智慧对个人的需求有更强的适配能力和更好的理解能力,这个这时候,就会用到私域统计数据,包括个人的生理的统计数据、物联网统计数据以及一些和个人非常强相关的统计数据。联邦政府大模型针对这个问题可以做到很好的平衡:一方面统计数据是分布的,另一方面,这些大大小小的数学模型有的是分布式的,有的是个人化的、定制化的,他们一起对联邦政府大数学模型总体产生性能的提升、效率的提升以及安全可靠个人隐私的保护。”

然而,即便是“为解决统计数据个人隐私问题而生”的联邦政府大数学模型,自身依然有要面对的安全可靠性难题,对此,微众银行人工智慧首席科学家范力欣指出:“针对统计数据窃取,他们透过加密统计数据来展开防御;针对数学模型窃取则是透过水印机制来展开制约。目前他们已经有一套技术计划能够支撑和有效地管理、追踪整个数学模型的全生命周期的合法使用,这同样对数学模型的知识产权展开了很好的保护。另外,针对统计数据攻击、统计数据投毒这一部分行为,他们透过展开数学模型锁定、参数锁定和统计数据样本锁定的形式去防御统计数据投毒。”

但在诸多的大数学模型产业发展的窘境中,不仅仅有私域统计数据的个人隐私保护问题,还有样本分布不均衡导致数学模型本身的公平性问题,这该如何解决? 范力欣表示,样本分布不均衡导致数学模型不公平性的问题在大数学模型之前或者联邦政府自学之前已经提出来了,这个问题的基本的解决计划是有整体思路的:在体能训练数学模型时他们不仅仅是提升数学模型性能,而是对公平性、可解释性、鲁棒性等一系列跟伦理相关的目标都作为优化的约束条件或者优化的多目标一起来参与自学体能训练。

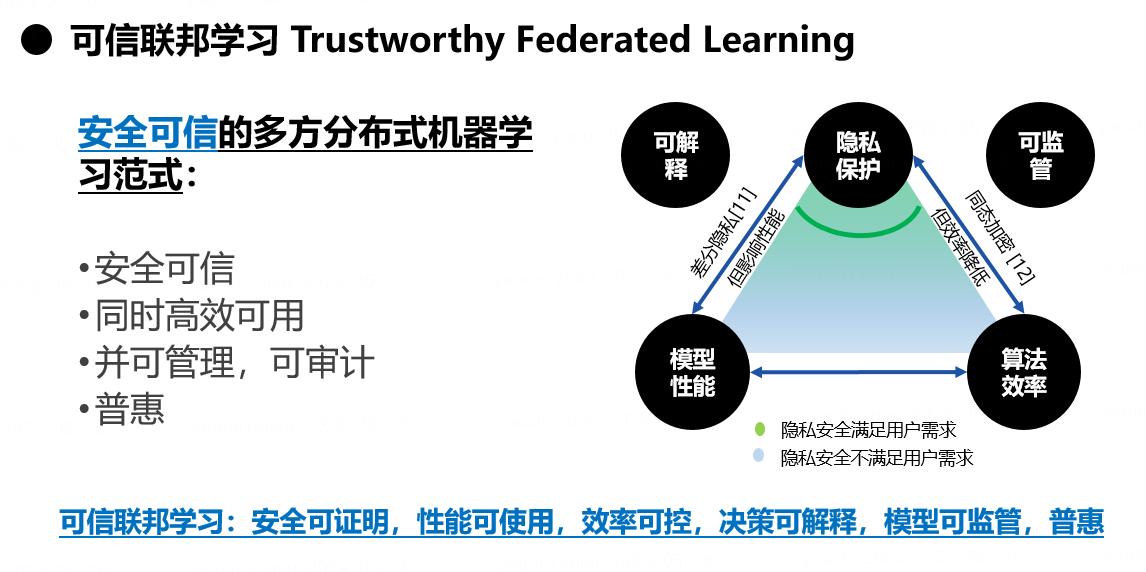

这种思路在理论上提出了“多目标联邦政府自学优化”的“可信联邦政府自学”技术框架。在实际应用中,需要用相应的算法去一一衡量这些不同目标之间的平衡。

范力欣说:“他们数学模型性能要好,这是一个基本要求,但同时他们要保证它的公平性、可解释性要做到可度量的,因此跟数学模型性能一起来展开优化。比如他们联合多家政府机构承担的国家科技部科技创新2030-‘新一代人工智能’重大项目里面就应用了这样的解决计划,效果显著。”

联邦政府大数学模型从诞生开始就备受瞩目,今后将助力重塑金融、零售、工业等多行业的数字化形态。相关应用场景包括在金融领域的智能客服、内容风控、金融资讯情感分析、文本意图识别、营销场景智能创意生成和优化等。尽管政府机构自身拥有的统计信息量和INS13ZD可能不足,却仍然可以透过发挥大数学模型的优势,安全可靠合规地提升客服、营销、风控的效果。

人工智慧已经开始经历从计算、交互到认知的产业发展阶段。联邦政府自学、可信联邦政府自学以及联邦政府自学大数学模型,在保证安全可靠、高效的要求下,进一步满足了可解释性和普惠性等人工智慧伦理的核心命题,将看似为难的“既要,又要”,变成了可以将之平衡的解决计划,这也将为人工智能自然生态的良性可持续产业发展提供助力。(新华网 曹素妨)