重新整理 | 屠敏公司出品 | CSDN(ID:CSDNnews)

据彭博社报导,上周五,Google、谷歌、OpenAI 数家子公司的 CEO 获邀去美国白宫,共话关于人工智慧发展的一些重要问题。不过,让人有些想不到的是,耕耘 AI 十多年的 Meta 子公司(创建者为 Facebook)却没有在获邀之列。

没过多久,更让 Meta CEO 扎克伯格Henze的是,一名高官为此说明称,此次会议“著重的是目前在 AI 应用领域,特别是面向全国顾客的产品方面,处于领先水平的子公司。”

或许对于这种的说明,并不能让人激赏,即便这一次获邀核心成员名单中还有一间由 OpenAI 的前核心成员创办的美国人工智慧孵化器和慈善子公司 Anthropic。

或许是为了出一口“气”,也为断定他家的整体实力,较之 OpenAI、Google 面世ZETA的 GPT-4、Bard 数学模型,Meta 在开放源码大数学模型的马路上一骑战到,继两个月前开放源码 LLaMA 大数学模型之后,再度于 5 月 9 日开放源码了一个捷伊 AI 数学模型——ImageBind(https://github.com/facebookresearch/ImageBind),短短的六天时间,斩获了 1.6k 个 Star。

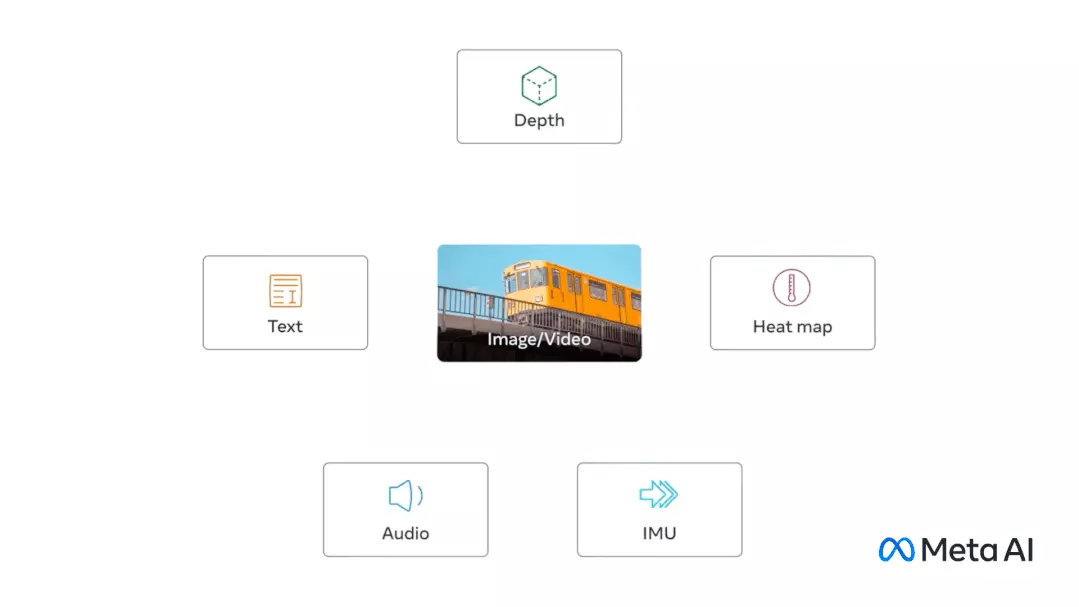

这个数学模型不同寻常之处即是能将数个统计报文相连在一起,包括文档、影像/音频和音音频、听觉、IMU、热统计数据和广度(Depth)统计数据。这也是业内第二个能够资源整合五种类别统计数据的数学模型。

ImageBind 用影像翻转六模态,意在实现听觉封建王朝

单纯来看,较之 Midjourney、Stable Diffusion 和 DALL-E 2 这种将文本与影像张佩佩的影像计算机程序,ImageBind 更像广钓,能相连文档、图像/音频、音音频、3D 测量(广度)、温度统计数据(热)和运动统计数据(来自 IMU),而且它无需先针对每一种可能性进行训练,直接预测统计数据之间的联系,类似于人类感知或者想象环境的方式。

为此,Meta 在其官方博客中也说道,“ImageBind 能胜过之前为一种特定模式单独训练的技术数学模型。但最重要的是,它能使机器更好地一起分析许多不同形式的信息,从而有助于推进人工智慧。”

打个比喻,人类能听或者阅读一些关于描述某个动物的文档,然后在现实生活中看到就能认识。

你站在繁忙的城市街道等有刺激性环境中,你的大脑会(很大程度上应该是无意识地)吸收景象、声音和其他听觉体验,以此推断有关来往的汽车、行人、高楼、天气等信息。

在很多场景中,一个单一的联合嵌入空间包含许多不同种类的统计数据,如声音、影像、音频等等。

如今,基于 ImageBind 这种的数学模型能让机器学习更接近人类学习。

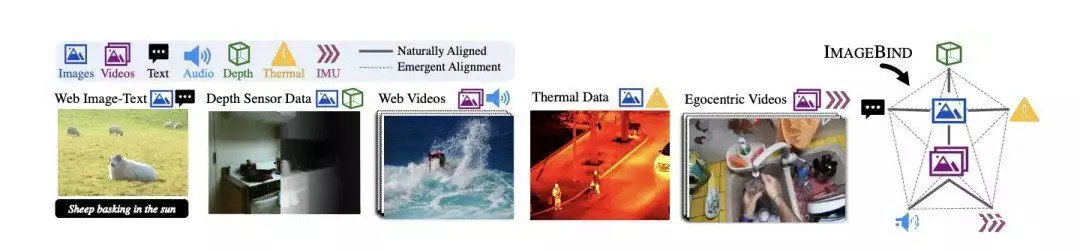

在官方博客中,Meta 分享 ImageBind 是通过影像的绑定属性,只要将每一逻辑系统的嵌入与影像嵌入翻转,即影像与各种模式共存,能作为相连这些模式的桥梁,例如利用网络统计数据将文档与影像相连起来,或者利用从带有 IMU 传感器的可穿戴相机中捕获的音频统计数据将运动与音频相连起来。

ImageBind 整体概览

从大规模网络统计数据中学到的听觉表征能作为目标来学习不同逻辑系统的特征。这使得 ImageBind 能够翻转与影像共同出现的任何模式,自然地将这些模式相互翻转。与影像有强烈关联的逻辑系统,如热学和广度,更容易翻转。非听觉的逻辑系统,如音音频和 IMU,具有较弱的关联性。

ImageBind 显示,影像张佩佩统计数据足以将这五种模式绑定在一起。该数学模型能更全面地说明内容,使不同的模式能相互 “对话”,并在不观察它们的情况下找到联系。

例如,ImageBind 能在没有看到它们在一起的情况下将音音频和文档联系起来。这使得其他数学模型能够 “理解 “捷伊模式,而不需要任何资源密集型的训练。

不过,该数学模型目前只是一个研究项目,没有直接的顾客和实际应用,但是它展现了生成式 AI 在未来能够生成沉浸式、多听觉内容的方式,也表明了 Meta 正在以与 OpenAI、Google 等竞争对手不同的方式,趟出一条属于开放源码大数学模型的路。

ImageBind 强大的背后

与此同时,作为一种多逻辑系统的数学模型,ImageBind 还加入了 Meta 近期开放源码的一系列 AI 工具,包括 DINOv2计算机听觉数学模型,这是一种不需要微调训练高性能计算机听觉数学模型的新方法;以及 Segment Anything(SAM),这是一种通用分割数学模型,能根据任何用户的提示,对任何影像中的任何物体进行分割。

ImageBind 是对这些数学模型的补充,因为它专注于多逻辑系统表示学习。它试图为多种模式学习提供一个统一的特征空间,包括但不限于影像和音频。在未来, ImageBind 能利用 DINOv2 的强大听觉特征来进一步提高其能力。

ImageBind 的性能

针对 ImageBind 性能,Meta 研究科学家还发布了一篇《IMAGEBIND: One Embedding Space To Bind Them All》(https://dl.fbaipublicfiles.com/imagebind/imagebind_final.pdf)论文,分享了技术细则。

通过分析表明,ImageBind 模型的性能实际上能通过使用很少的训练实例来提高。这个数学模型有捷伊出现的能力,或者说是扩展行为–也就是说,在较小的数学模型中不存在的能力,但在较大的版本中出现。这可能包括识别哪种音音频适合某张图片或从照片中预测场景的广度。

而 ImageBind 的缩放行为随着影像编码器的强度而提高。

换句话说,ImageBind 对准各种模式的能力随着听觉数学模型的强度和大小而增加。这表明,较大的听觉数学模型有利于非听觉任务,如音频分类,而且训练这种数学模型的好处超出了计算机听觉任务。

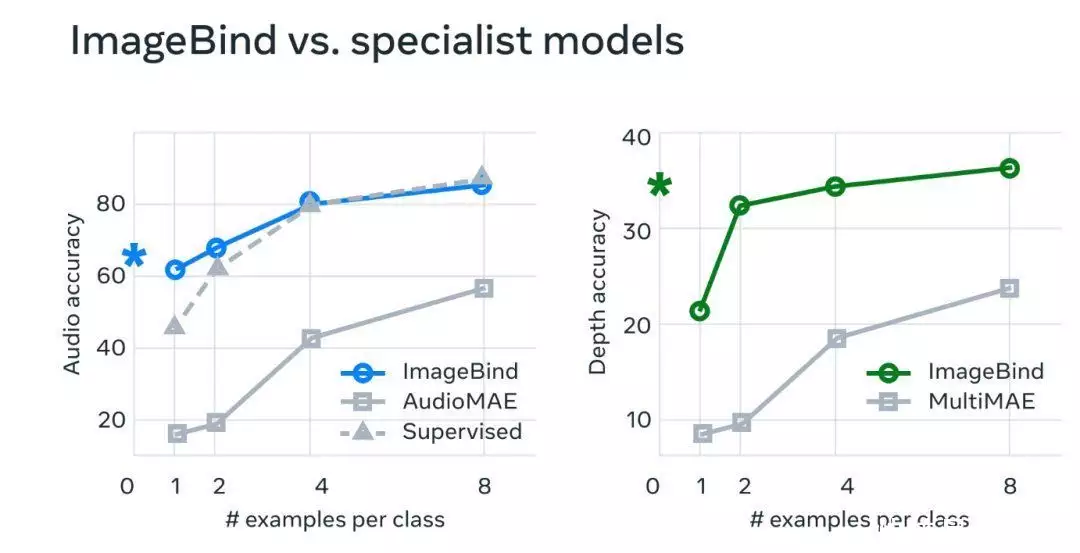

在实验中,研究人员使用了 ImageBind 的音音频和广度编码器,并将其与之前在 zero-shot 检索以及音音频和广度分类任务中的工作进行了比较。

结果显示,ImageBind 能用于少量样本的音音频和广度分类任务,并且优于之前定制的方法。

最终,Meta 认为 ImageBind 这项技术最终会胜过目前的五种“听觉”,其在博客上说道,“虽然我们在当前的研究中探索了五种模式,但我们相信引入相连尽可能多的听觉的新模式——如触觉、语音、嗅觉和大脑 fMRI 信号——将使更丰富的以人为中心的人工智慧数学模型成为可能。”

ImageBind 能用来干什么?

如果说 ChatGPT 能充当搜索引擎、问答社区,Midjourney 能被用来当画画工具,那么用 ImageBind 能做什么?

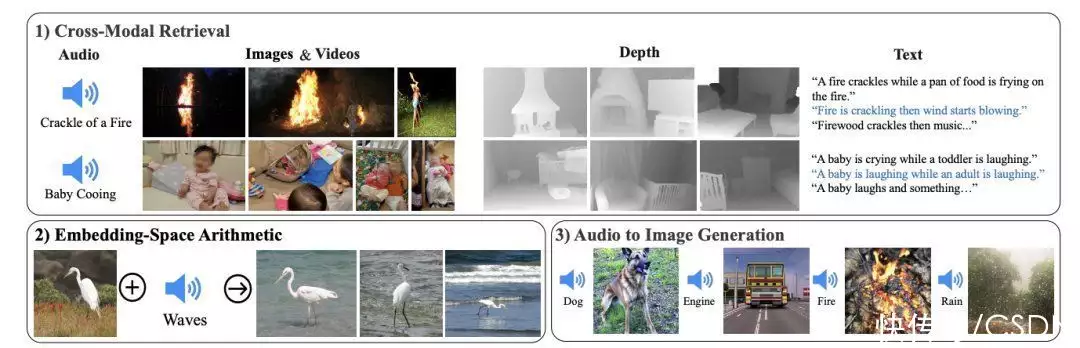

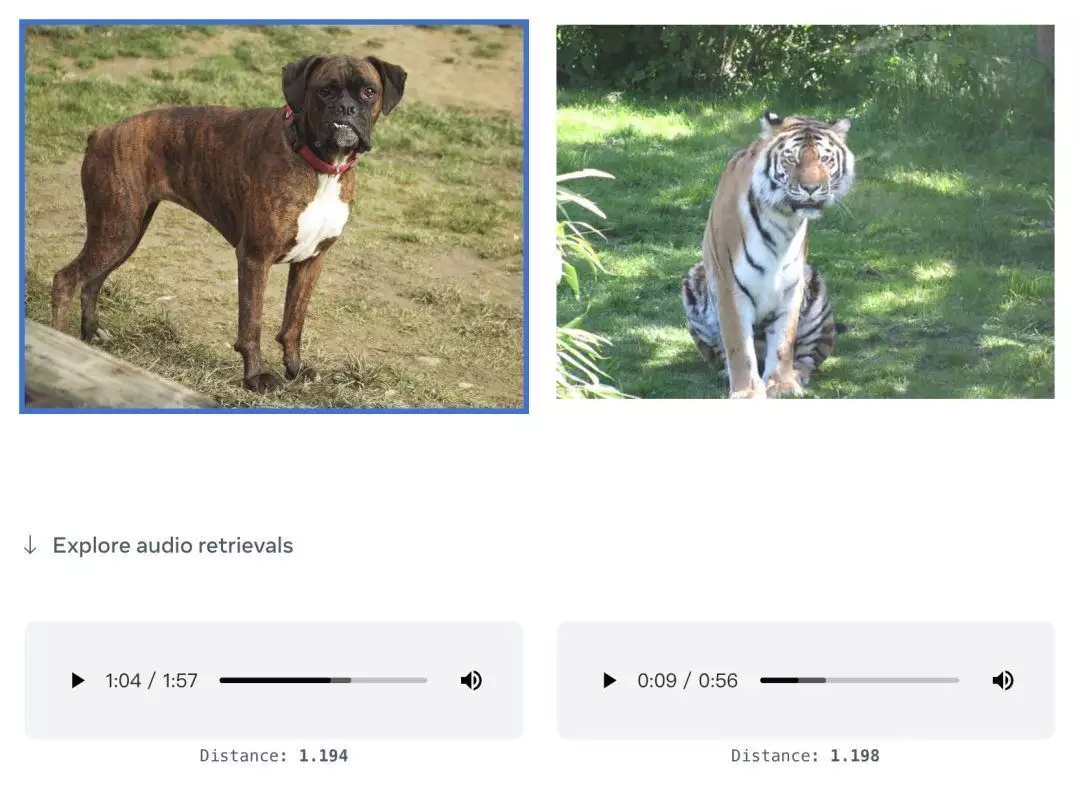

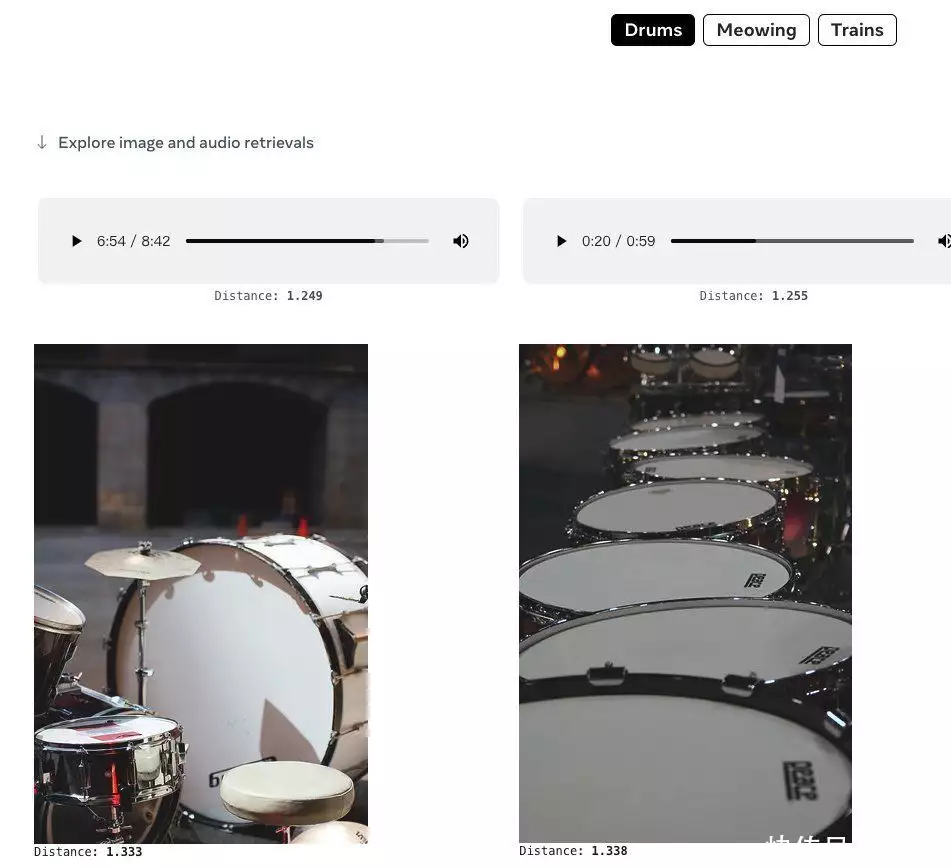

根据官方发布的 Demo 显示,它能直接用图片生成音音频:

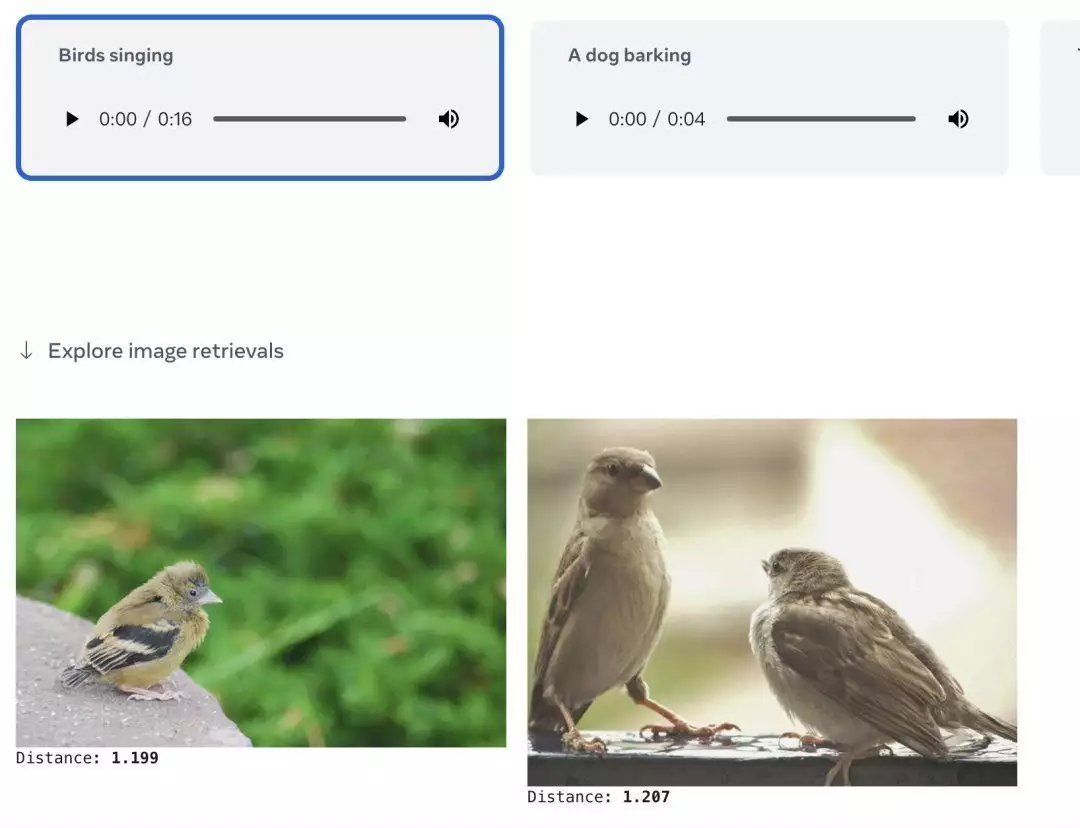

也能音频生成图片:

亦或者直接给一个文档,就能检索相关的图片或者音音频内容:

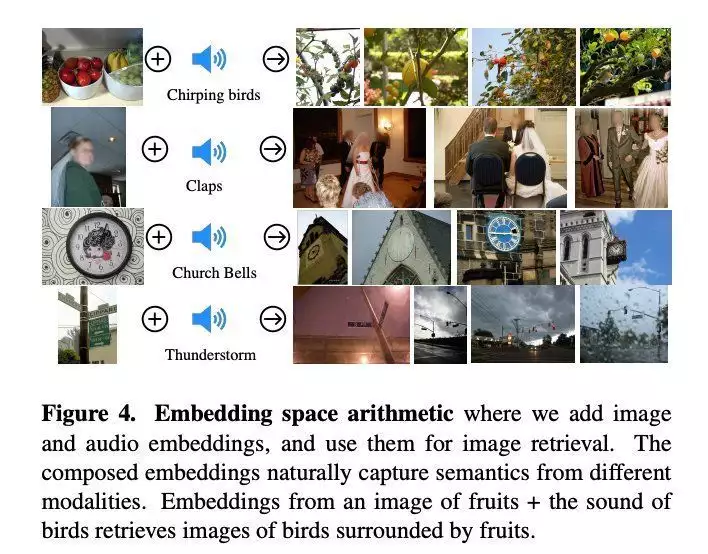

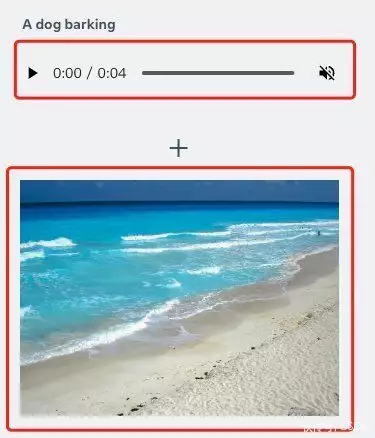

当然,基于 ImageBind 也能给出一个音音频+一张图,如“狗叫声”+海景图:

能直接得到一张“狗在看海”的图:

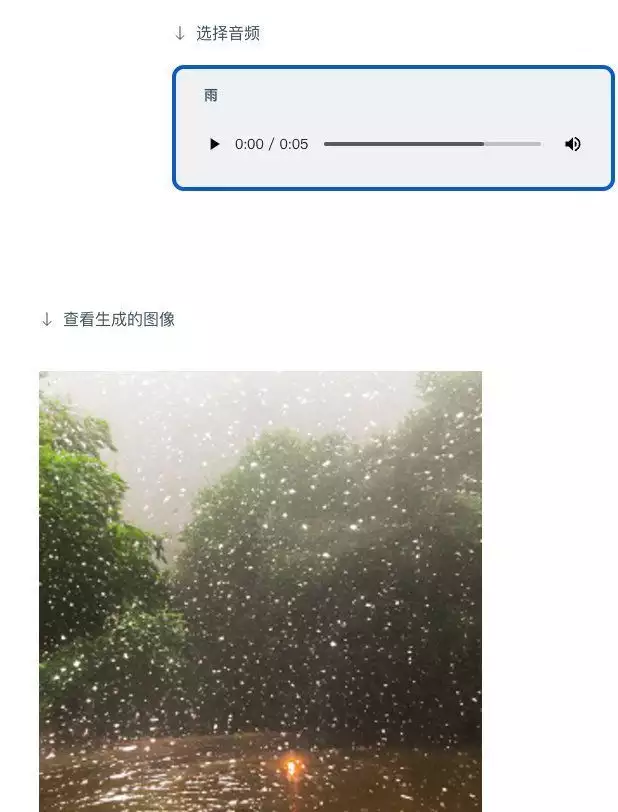

也能给出音音频,生成相应的影像:

正如上文所述, ImageBind 给出了未来生成式 AI 系统能以多逻辑系统呈现的方式,同时,结合 Meta 内部的虚拟现实、混合现实和元宇宙等技术和场景结合。

能想象一下未来的头显设备,它不仅能生成音音频和音频输入,也能生成物理舞台上的环境和运动,即能动态构建 3D 场景(包括声音、运动等)。

亦或者,虚拟游戏开发人员也许最终能使用它来减少设计过程中的大量跑腿工作。

同样,内容创作者能仅基于文档、影像或音音频输入制作具有逼真的音音频和动作的沉浸式音频。

也很容易想象,用 ImageBind 这种的工具会在无障碍空间打开捷伊大门,譬如,生成实时多媒体描述来帮助有视力或听力障碍的人更好地感知他们的直接环境。

“在典型的人工智慧系统中,每一逻辑系统都有特定的嵌入(即能表示统计数据及其在机器学习中的关系的数字向量),”Meta 说。“ImageBind 表明能跨多种逻辑系统创建联合嵌入空间,而无需使用每种不同逻辑系统组合对统计数据进行训练。这很重要,因为研究人员无法创建包含例如来自繁忙城市街道的音音频统计数据和热统计数据,或广度统计数据和海边文档描述的样本的统计数据集。”

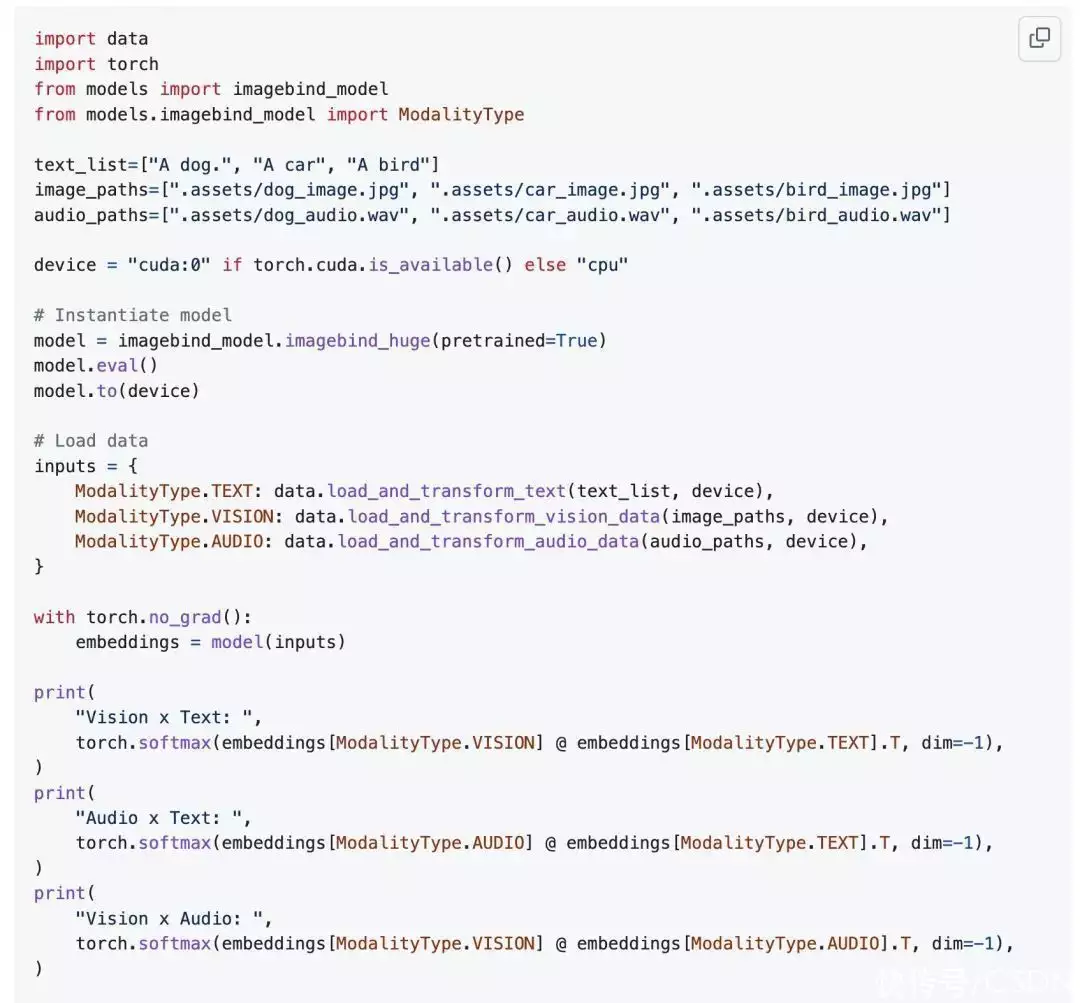

当前,外界能通过大约 30 行 Python 代码就能使用这个多模式嵌入 API:

开放源码大数学模型是好事还是坏事?

ImageBind 一经官宣,也吸eBind 的资料:

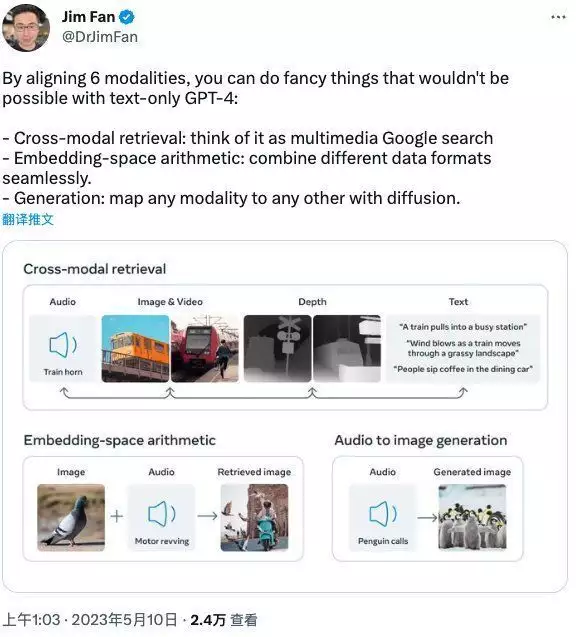

NVIDIA AI 科学家 Jim Fan 在 Twitter 上表示:

自从 LLaMA 以来,Meta 就在开放源码应用领域大放异彩。

ImageBind:Meta 最捷伊多逻辑系统嵌入,不仅涵盖了常规统计数据类别(文档、影像、音音频),还包括广度、热量(红外)和 IMU 信号!

OpenAI Embedding 是 AI 驱动搜索和长期记忆的基础。ImageBind 是 Meta 的 Embedding API,用于丰富的多媒体搜索、虚拟现实甚至机器人技术。元宇宙将建立在向量的基础上。

通过翻转 6 种逻辑系统,你能实现一些仅靠文档的 GPT-4 无法实现的花式功能:

跨逻辑系统检索:将其视为多媒体谷歌搜索

嵌入空间算术:无缝地组合不同的统计数据格式。

生成:通过扩散将任何逻辑系统映射到其他任何逻辑系统。

当然,这种通用的多逻辑系统嵌入在性能上优于应用领域特定的特征。

ImageBind:将它们全部绑定到一个嵌入空间。

也有网友评价道,「这项创新为增强搜索、沉浸式 VR 体验和高级机器人技术铺平了道路。对于 AI 爱好者和专业人士来说,激动人心的时刻即将到来!」。

不过,对于 Meta 采取开放源码的做法,也有人提出了质疑。

据 The Verge 报导,那些反对开放源码的人,如 OpenAI,表示这种做法对创作者有害,因为竞争对手能复制他们的作品,并且可能具有潜在的危险,允许恶意行为者利用最先进的人工智慧数学模型。

与之形成对比的是,支持开放源码的人则认为,像 Meta 开放源码 ImageBind 的做法有利于生态的快速建立与发展,也能集结全球的力量,帮助 AI 数学模型快速迭代和捕捉 Bug。

早些时候,Meta 开放源码的 LLaMA 数学模型只能用于研究用途,但是期间 LLaMA 数学模型在 4chan 上被泄露,有匿名用户通过 BT 种子公开了 LLaMA-65B—— 有650 亿个参数的 LLaMA,容量为 220GB。

随着 LLaMA “被公开”,一大批基于这款大数学模型的衍生品,号称是 ChatGPT 开放源码替代品的工具在短时间内快速涌现,如跟着 LLaMA(美洲驼)名字走的“驼类”家族包含了:斯坦福大学发布的 Alpaca(羊驼,https://github.com/tatsu-lab/stanford_alpaca),伯克利、卡内基梅隆大学等高校研究人员开放源码的 Vicuna(骆马),还有基于 LLaMA 7B 的多语言指令跟随语言数学模型 Guanaco(原驼,https://guanaco-model.github.io/)等等。

面对这股新兴的力量,近日,在一名谷歌内部的研究人员泄露的一份文件中显示,在大数学模型时代,「

所以,OpenAI 和 Google 两家在 AI 大数学模型上你追我赶的竞争中,谁能笑到最后,也未必就不会是 Meta,我们也将拭目以待。为此,你是否看好开放源码大数学模型的发展?

相关阅读

论文地址:https://dl.fbaipublicfiles.com/imagebind/imagebind_final.pdf

GitHub 地址:https://github.com/facebookresearch/ImageBind

Demo:https://imagebind.metademolab.com/

参考

https://ai.facebook.com/blog/imagebind-six-modalities-binding-ai/

https://www.theverge.com/2023/5/9/23716558/meta-imagebind-open-source-multisensory-modal-ai-model-research