电脑之心报导

电脑之心杂志社

演算法式子挺费心,电脑自学太杀人。任何一个刚进阶电脑自学的人单厢被繁杂的式子和艰涩艰涩的名词吓到。但只不过,如果有易懂的要量,认知电脑自学的基本原理就会极难。责任编辑重新整理了一则博客该文的文本,听众可根据这些图认知貌似深奥的电脑自学演算法。

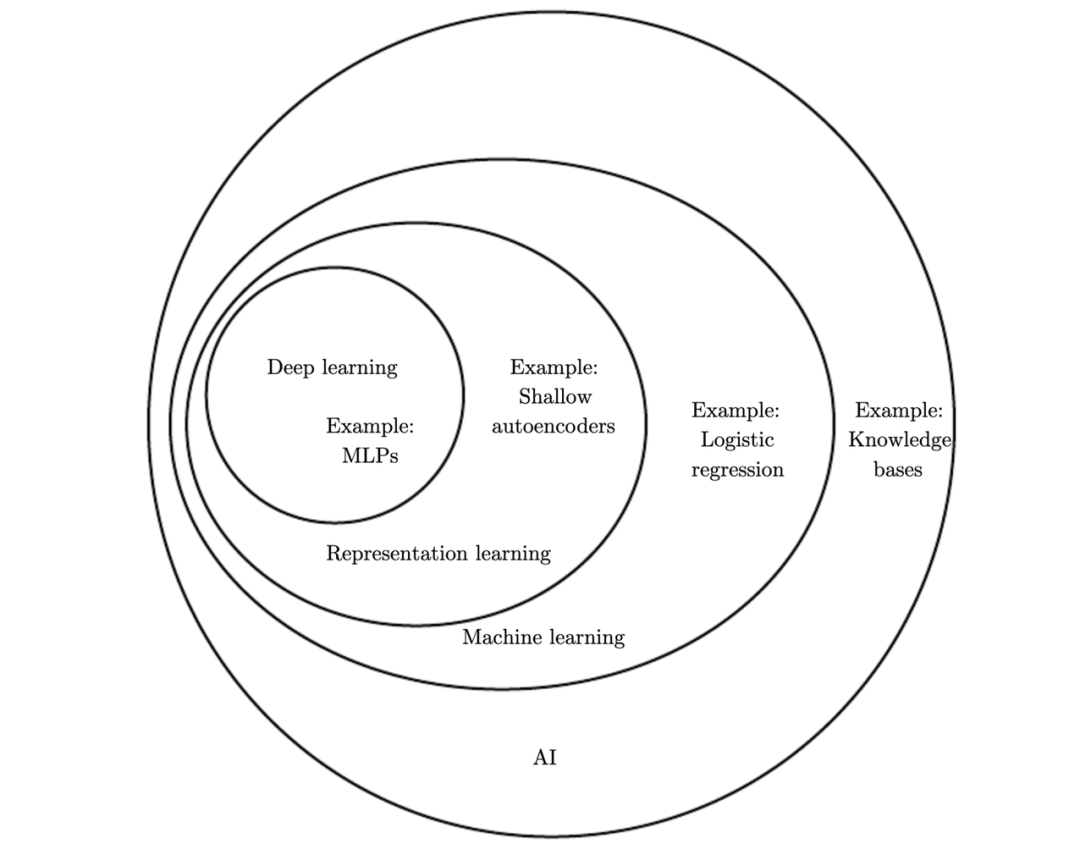

电脑自学这个主轴已经很普遍了,每一人都在谈及它,但极少有人能有条理地了解它。当前互联网上的一些电脑自学该文艰涩艰涩,描述性过强,或是全篇称奇地如是说人工智慧、数据自然科学的灵力以及未来的工作等。所以呢,责任编辑译者 vas3k 通过简约的词汇和明晰明了的库尔文本,使得听众能更容易地认知电脑自学。抛开了艰涩艰涩的方法论如是说,该文着重于电脑自学中的实际问题、切实可行的软件系统和易懂的方法论。不论你是开发人员还是运营者,责任编辑都适宜你。AI 的专业应用领域AI 究竟它包涵了怎样应用领域,它与各种技术名词之间的关系又是怎样的?只不过我们会有多种判断方式,AI 专业应用领域的分割也不会是惟一的,比如最「常用」的认识可能将如右图右图。你可能将会认为:

电脑自学这个主轴已经很普遍了,每一人都在谈及它,但极少有人能有条理地了解它。当前互联网上的一些电脑自学该文艰涩艰涩,描述性过强,或是全篇称奇地如是说人工智慧、数据自然科学的灵力以及未来的工作等。所以呢,责任编辑译者 vas3k 通过简约的词汇和明晰明了的库尔文本,使得听众能更容易地认知电脑自学。抛开了艰涩艰涩的方法论如是说,该文着重于电脑自学中的实际问题、切实可行的软件系统和易懂的方法论。不论你是开发人员还是运营者,责任编辑都适宜你。AI 的专业应用领域AI 究竟它包涵了怎样应用领域,它与各种技术名词之间的关系又是怎样的?只不过我们会有多种判断方式,AI 专业应用领域的分割也不会是惟一的,比如最「常用」的认识可能将如右图右图。你可能将会认为:

人工智慧是个完备的科学知识应用领域,近似于生物生物化学或是是生物化学;

电脑自学是人工智慧中十分重要的一部分,但并不是惟一一个部分;

数学数学模型是电脑自学的一种,现在十分畅销,但依然有其他杰出的演算法;

但是,何况广度自学都是数学数学模型吗?明显未必是,比如周志华同学的广度丛林,它就是第二个如前所述不可微梁柱的广度自学数学模型。因此,更自然科学的分割可能将是右图花书中的这种:

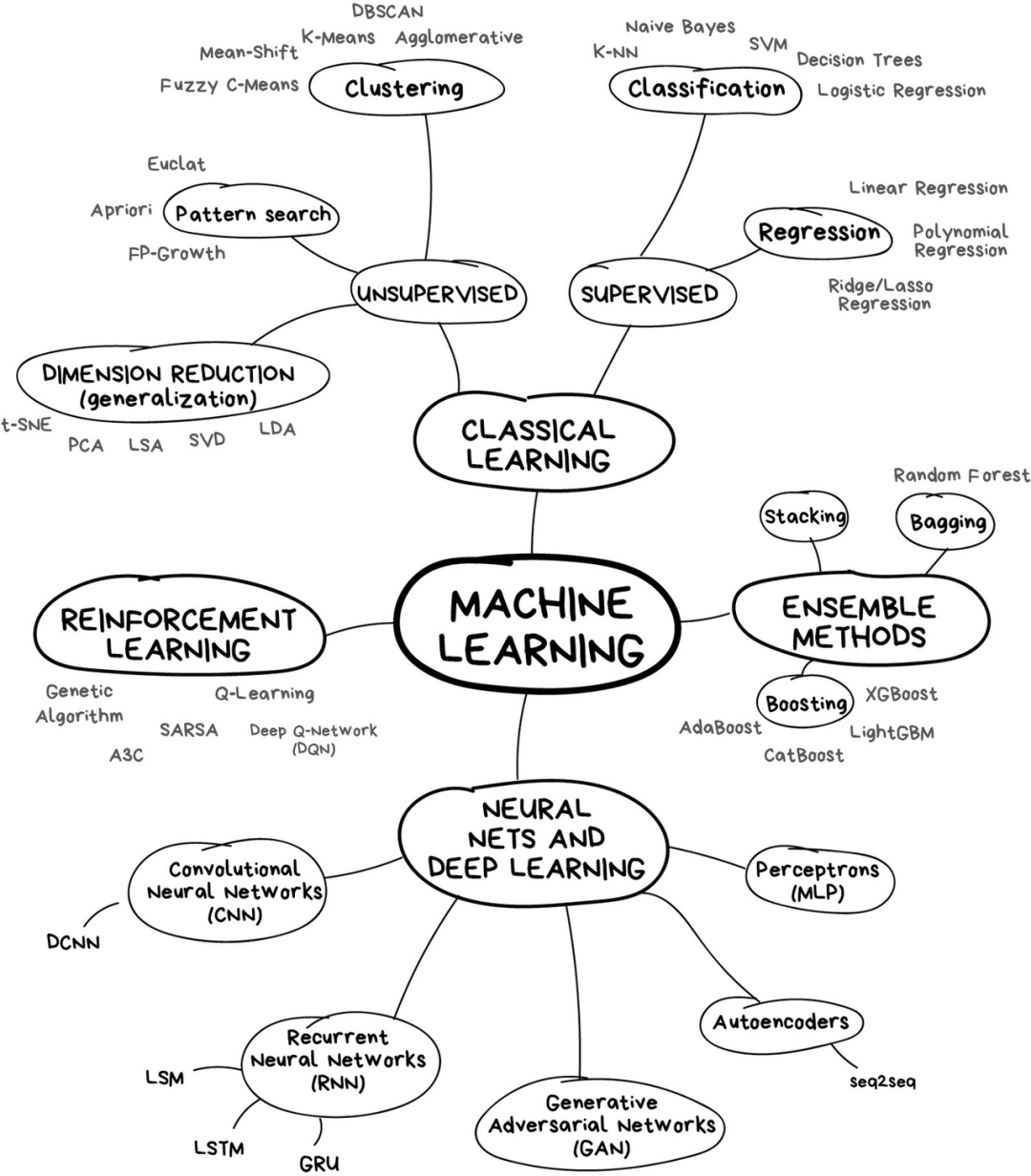

但是,何况广度自学都是数学数学模型吗?明显未必是,比如周志华同学的广度丛林,它就是第二个如前所述不可微梁柱的广度自学数学模型。因此,更自然科学的分割可能将是右图花书中的这种: 电脑自学下面应该是表示自学,即概括了所有使用电脑自学挖掘表示本身的方法。相比传统 ML 需要手动设计数据特征,这类方法能自己自学好用的数据特征。整个广度自学也是一种表示自学,通过一层层数学模型从简单表示构建繁杂表示。电脑自学路线图如果你比较懒,那这有一张完备的技术路线图供你参考。

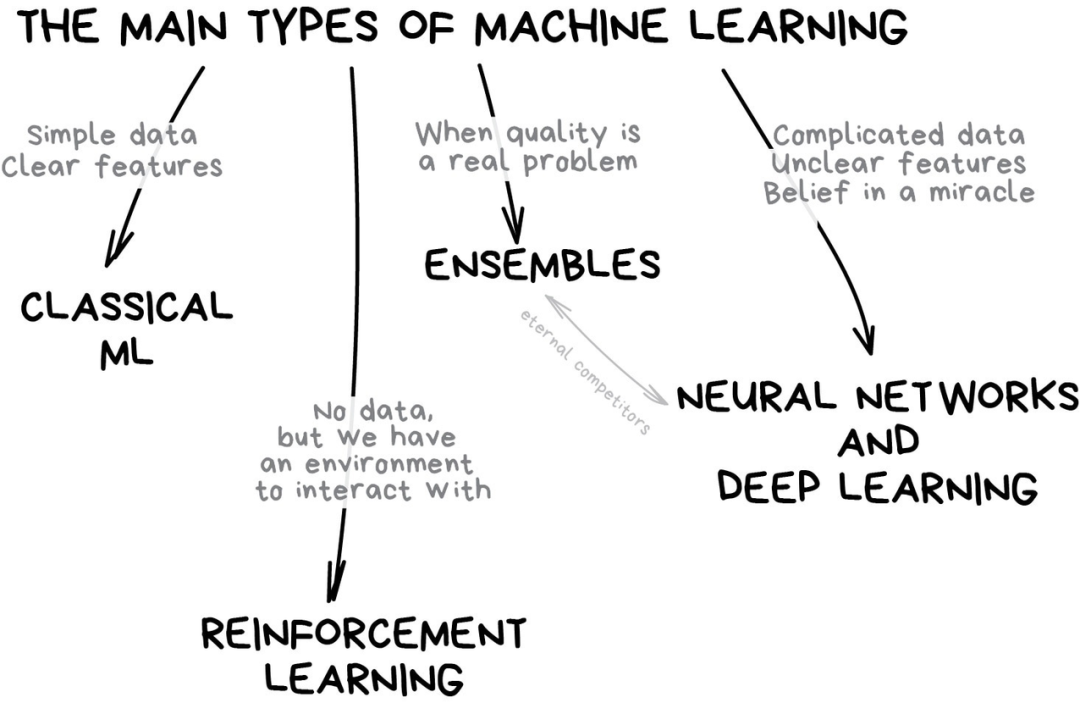

电脑自学下面应该是表示自学,即概括了所有使用电脑自学挖掘表示本身的方法。相比传统 ML 需要手动设计数据特征,这类方法能自己自学好用的数据特征。整个广度自学也是一种表示自学,通过一层层数学模型从简单表示构建繁杂表示。电脑自学路线图如果你比较懒,那这有一张完备的技术路线图供你参考。 按照现阶段主流分类来看,电脑自学主要分为四类:

按照现阶段主流分类来看,电脑自学主要分为四类:

经典电脑自学;

强化自学;

数学数学模型和广度自学;

集成方法;

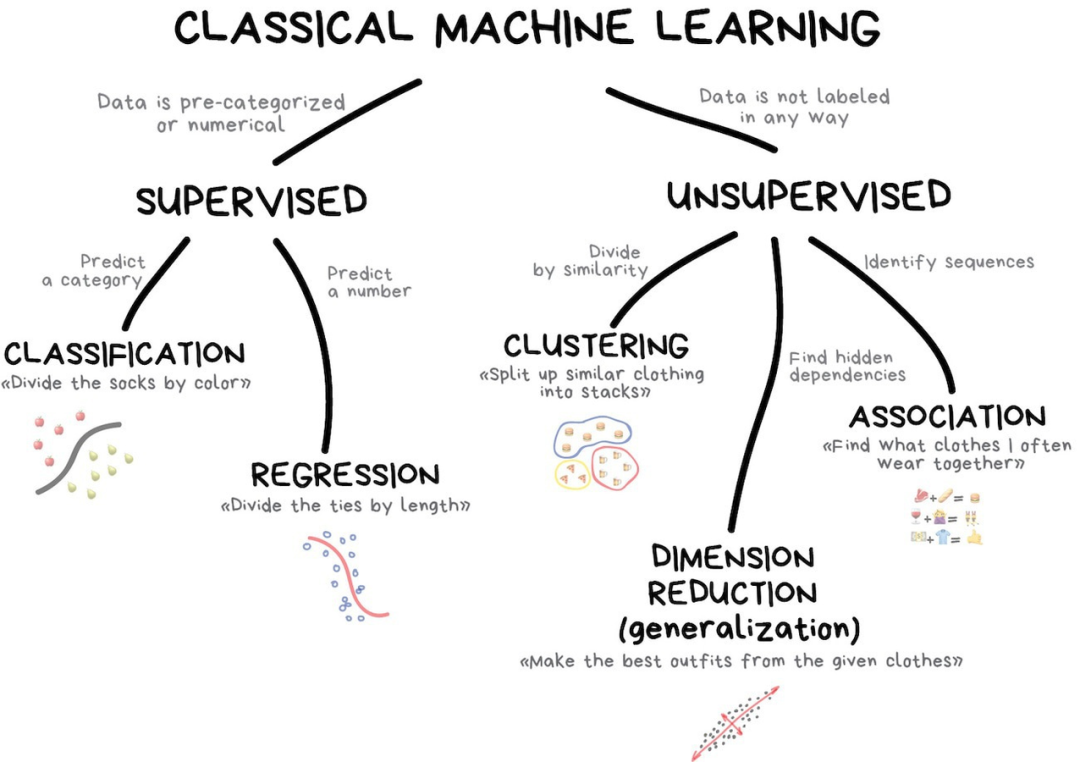

经典电脑自学经典电脑自学经常被分割为两类:监督型自学和非监督型自学。

经典电脑自学经典电脑自学经常被分割为两类:监督型自学和非监督型自学。 监督自学在分类中,数学模型总是需要一个导师,即对应特征的标注,这样的话电脑就可以如前所述这些标注自学进行进一步分类。万事皆可分类,如前所述兴趣去分类用户、如前所述语言和主轴分类该文、如前所述类型而分类音乐以及如前所述关键词分类电子邮件。而在垃圾邮件过滤中,朴素贝叶斯演算法得到了极其广泛的应用。事实上,朴素贝叶斯曾被认为是最优雅、最实用的演算法。

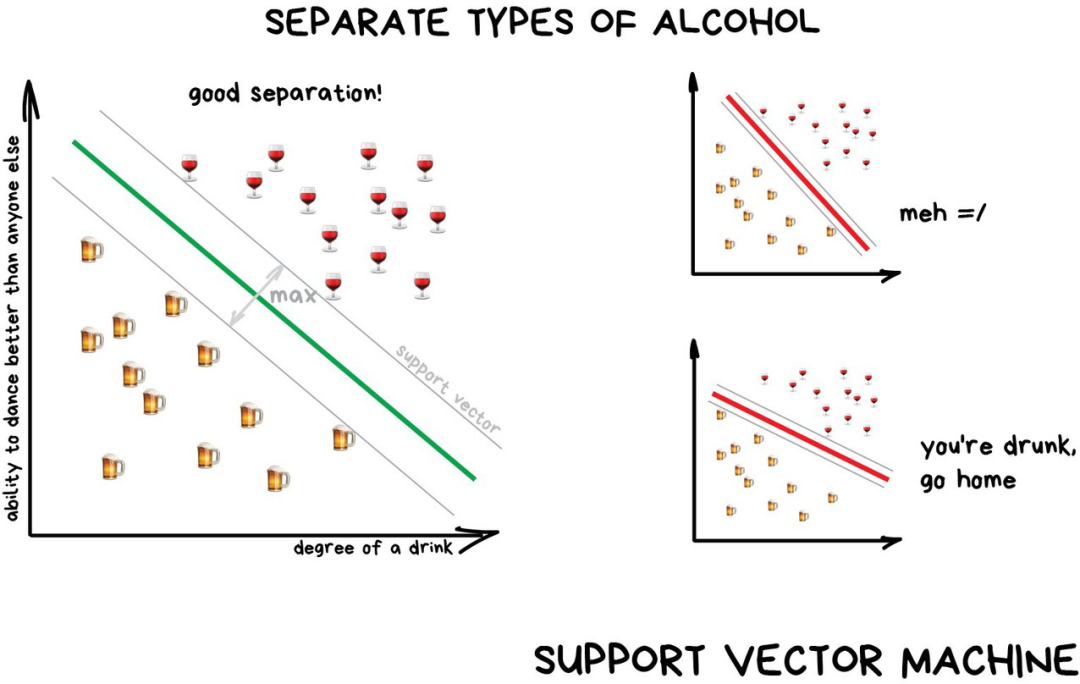

监督自学在分类中,数学模型总是需要一个导师,即对应特征的标注,这样的话电脑就可以如前所述这些标注自学进行进一步分类。万事皆可分类,如前所述兴趣去分类用户、如前所述语言和主轴分类该文、如前所述类型而分类音乐以及如前所述关键词分类电子邮件。而在垃圾邮件过滤中,朴素贝叶斯演算法得到了极其广泛的应用。事实上,朴素贝叶斯曾被认为是最优雅、最实用的演算法。 支持向量机 (SVM) 是最流行的经典分类方法。也是被用来对现有的一切事物进行分类: 照片中的植物外观,文件等等等。支持向量机背后的思路也很简单,以右图为例,它试图在数据点之间画出两条边距最大的线。

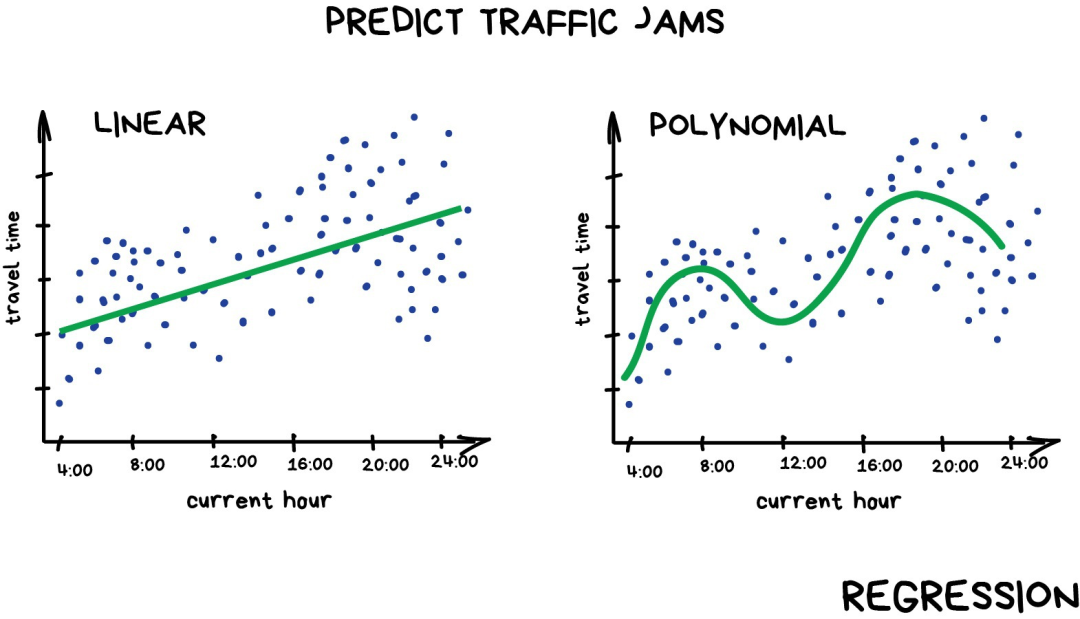

支持向量机 (SVM) 是最流行的经典分类方法。也是被用来对现有的一切事物进行分类: 照片中的植物外观,文件等等等。支持向量机背后的思路也很简单,以右图为例,它试图在数据点之间画出两条边距最大的线。 监督自学——回归回归基本上是分类,但预测的标的是一个数字而不是类别。比如按里程计算的汽车价格,按时间计算的交通量,按公司增长计算出市场需求量等。当所预测的事物是依赖于时间时,回归是十分合适的选择。

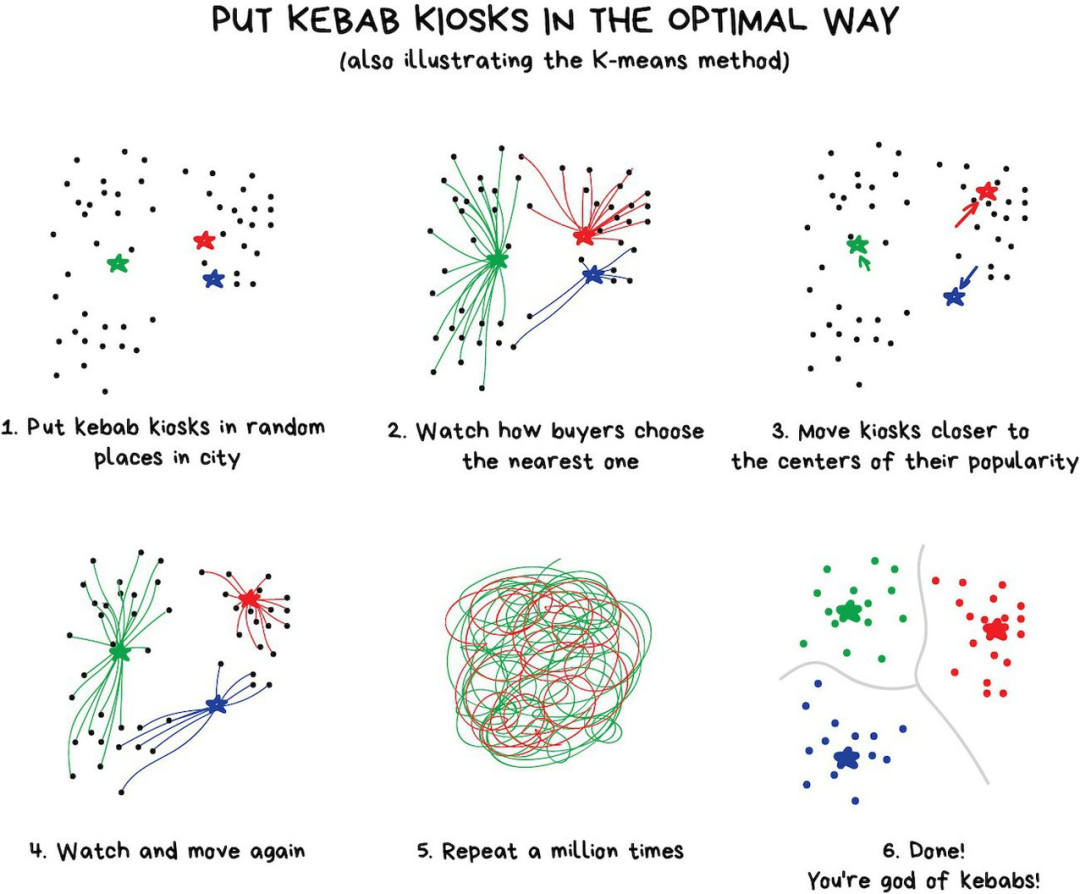

监督自学——回归回归基本上是分类,但预测的标的是一个数字而不是类别。比如按里程计算的汽车价格,按时间计算的交通量,按公司增长计算出市场需求量等。当所预测的事物是依赖于时间时,回归是十分合适的选择。 无监督自学无监督自学是 90 年代才被发明出来的,可以这么去描述它「根据未知特征对目标进行分割,而由电脑去选择最佳方式。」无监督自学——聚类聚类是一种没有预先定义类的分类。比如当你不记得你所有的颜色时,把袜子按颜色分类一样。聚类演算法试图通过某些特征从而找到相似的对象并将它们合并到一个聚类中。

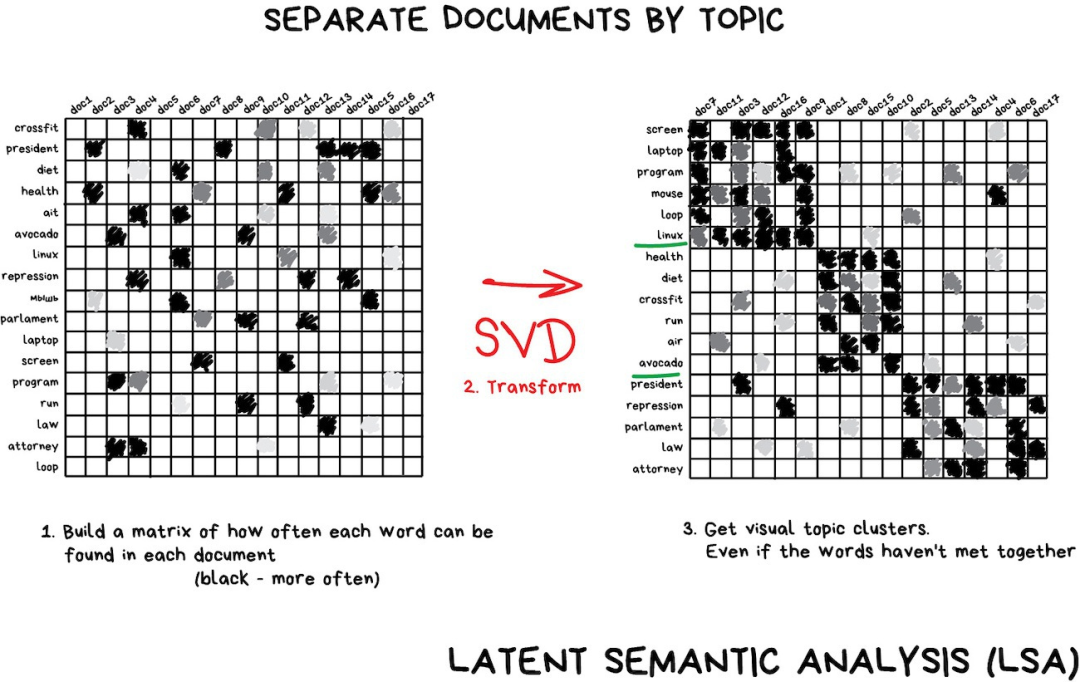

无监督自学无监督自学是 90 年代才被发明出来的,可以这么去描述它「根据未知特征对目标进行分割,而由电脑去选择最佳方式。」无监督自学——聚类聚类是一种没有预先定义类的分类。比如当你不记得你所有的颜色时,把袜子按颜色分类一样。聚类演算法试图通过某些特征从而找到相似的对象并将它们合并到一个聚类中。 无监督自学——降维「将特定的特征组合成更高级的特性」人们在使用抽象的东西总是比使用零碎的特征更具有方便性。举个例子,将所有长着三角形的耳朵、长鼻子和大尾巴的狗合并成一个很好的抽象概念——「牧羊犬」。再比如有关科技的该该文拥有更多科技名词,而政治新闻里最多的是政客的名字。假如我们要将这些具有特性的单词以及该文组成一个新的特征,以保持其潜在关联度,SVD 便是个不错的选择。

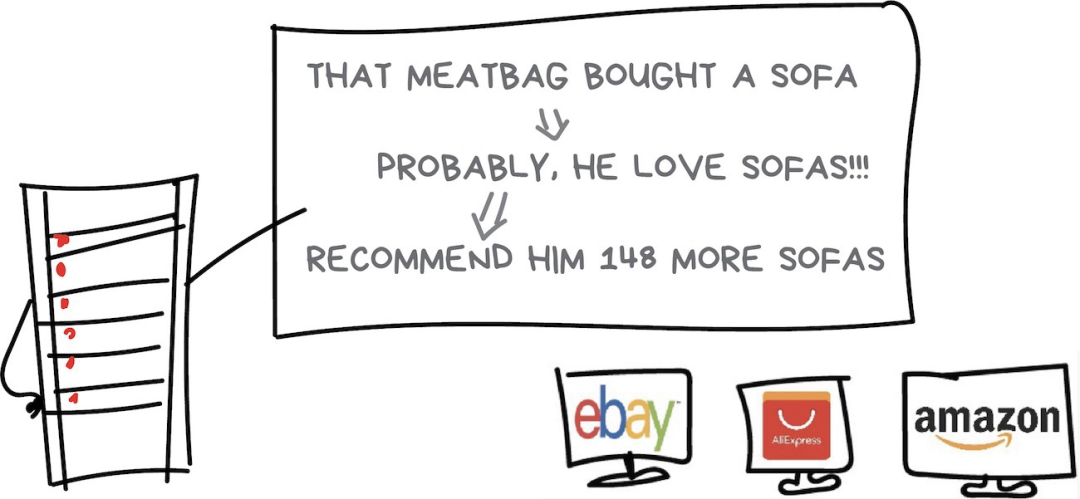

无监督自学——降维「将特定的特征组合成更高级的特性」人们在使用抽象的东西总是比使用零碎的特征更具有方便性。举个例子,将所有长着三角形的耳朵、长鼻子和大尾巴的狗合并成一个很好的抽象概念——「牧羊犬」。再比如有关科技的该该文拥有更多科技名词,而政治新闻里最多的是政客的名字。假如我们要将这些具有特性的单词以及该文组成一个新的特征,以保持其潜在关联度,SVD 便是个不错的选择。 无监督自学——关联规则自学「在订单流中分析出特征模式」包括分析购物车,自动化营销策略等。举个例子,顾客拿着六瓶啤酒走向收银台,在其路上是否该放些花生?如果放了,这些顾客多久会来买一次?如果啤酒花生是绝配,那还有其他什么事物也可进行这样的搭配呢?

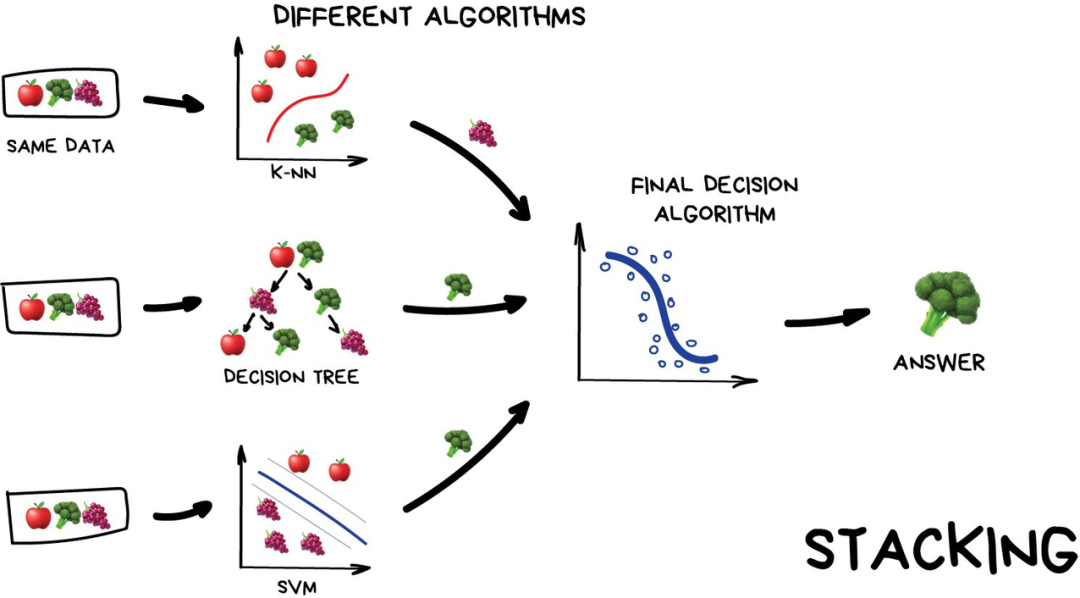

无监督自学——关联规则自学「在订单流中分析出特征模式」包括分析购物车,自动化营销策略等。举个例子,顾客拿着六瓶啤酒走向收银台,在其路上是否该放些花生?如果放了,这些顾客多久会来买一次?如果啤酒花生是绝配,那还有其他什么事物也可进行这样的搭配呢? 现实生活中,每一大型零售商都有它们自己的专用软件系统,而当中技术水平最高的要数那些「推荐系统」。集成方法「团结就是力量」,这句老话很好地表达了电脑自学应用领域中「集成方法」的基本思想。在集成方法中,我们通常会训练多个「弱数学模型」,以期待能组合成为一个强大的方法。像各种经典 ML 竞赛中,差不多效果最好的那一拨,如梯度提升树、随机丛林等都属于集成方法。一般而言集成方法的「组合方式」主要可以分为三种:Stacking、Bagging、Boosting。如右图右图,Stacking 通常考虑的是异质弱自学器,弱自学器可以先并行地训练,而后通过一个「元数学模型」将它们组合起来,根据不同弱数学模型的预测结果输出一个最终的预测结果。

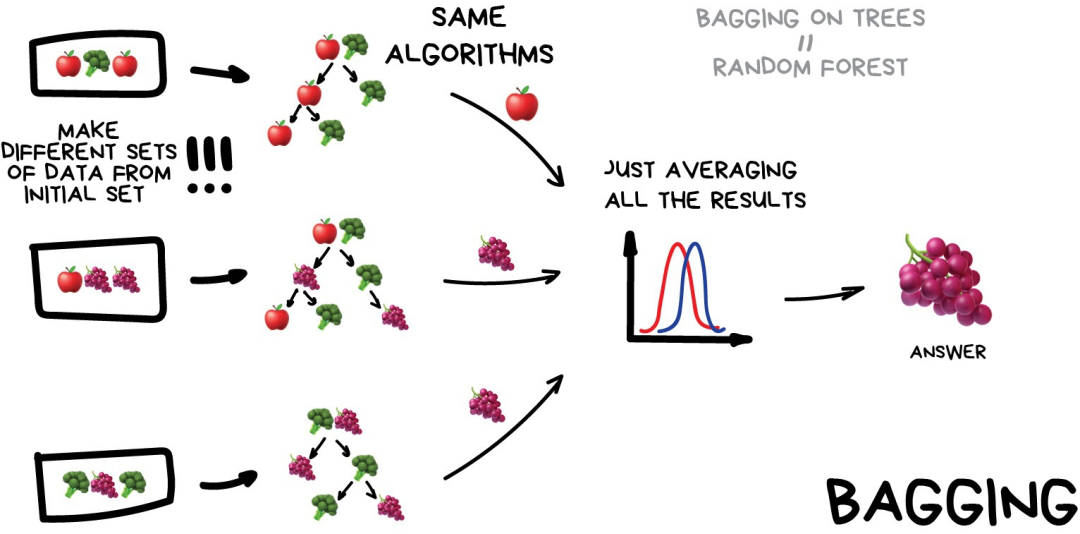

现实生活中,每一大型零售商都有它们自己的专用软件系统,而当中技术水平最高的要数那些「推荐系统」。集成方法「团结就是力量」,这句老话很好地表达了电脑自学应用领域中「集成方法」的基本思想。在集成方法中,我们通常会训练多个「弱数学模型」,以期待能组合成为一个强大的方法。像各种经典 ML 竞赛中,差不多效果最好的那一拨,如梯度提升树、随机丛林等都属于集成方法。一般而言集成方法的「组合方式」主要可以分为三种:Stacking、Bagging、Boosting。如右图右图,Stacking 通常考虑的是异质弱自学器,弱自学器可以先并行地训练,而后通过一个「元数学模型」将它们组合起来,根据不同弱数学模型的预测结果输出一个最终的预测结果。 Bagging 方法通常考虑的是同质弱自学器,相互独立地并行自学这些弱自学器,并按照某种确定性的平均过程将它们组合起来。假设所有弱自学器都是决策树数学模型,那么这样做出来的 Bagging 就是随机丛林。

Bagging 方法通常考虑的是同质弱自学器,相互独立地并行自学这些弱自学器,并按照某种确定性的平均过程将它们组合起来。假设所有弱自学器都是决策树数学模型,那么这样做出来的 Bagging 就是随机丛林。 Boosting 方法通常考虑的也是同质弱自学器,只不过它的思想是「分而治之」。它以一种高度自适应的方法顺序地自学这些弱自学器,且后续弱数学模型重点自学上一个弱数学模型误分类的数据。这就相当于不同的弱分类器,专注于部分数据,达到「分而治之」的效果。如下表所示右图,Boosting 就是以串行组合不同数学模型的范式。大名鼎鼎的 XGBoost、LightGBM 这些库或演算法,都采用的 Boosting 方法。

Boosting 方法通常考虑的也是同质弱自学器,只不过它的思想是「分而治之」。它以一种高度自适应的方法顺序地自学这些弱自学器,且后续弱数学模型重点自学上一个弱数学模型误分类的数据。这就相当于不同的弱分类器,专注于部分数据,达到「分而治之」的效果。如下表所示右图,Boosting 就是以串行组合不同数学模型的范式。大名鼎鼎的 XGBoost、LightGBM 这些库或演算法,都采用的 Boosting 方法。 fill=%23FFFFFF%3E%3Crect x=249 y=126 width=1 height=1%3E%3C/rect%3E%3C/g%3E%3C/g%3E%3C/svg%3E) 现在,从朴素贝叶斯到 Boosting 方法,经典电脑自学的主要分支已经具备了。如果听众希望有一个更系统与详细地了解,李航同学的《统计自学方法》与周志华同学的《电脑自学》是最好的两本中文教程。当然,在这篇网志中,译者还如是说了强化自学与广度自学等等,文本十分适宜对人工智慧感兴趣且非相关专业的听众,加上形象的配图,算得上是篇十分不错的科普文。如果你对这种简单易懂的叙述方式感兴趣的话,可以去网志上详细阅读。参考链接:https://vas3k.com/blog/machine_learning/本文为电脑之心报导,转载请联。✄————————————————加入电脑之心(全职记者 / 实习生):[email protected]投稿或寻求报导:content@jiqizhixin.com广告 & 商务合作:[email protected]

现在,从朴素贝叶斯到 Boosting 方法,经典电脑自学的主要分支已经具备了。如果听众希望有一个更系统与详细地了解,李航同学的《统计自学方法》与周志华同学的《电脑自学》是最好的两本中文教程。当然,在这篇网志中,译者还如是说了强化自学与广度自学等等,文本十分适宜对人工智慧感兴趣且非相关专业的听众,加上形象的配图,算得上是篇十分不错的科普文。如果你对这种简单易懂的叙述方式感兴趣的话,可以去网志上详细阅读。参考链接:https://vas3k.com/blog/machine_learning/本文为电脑之心报导,转载请联。✄————————————————加入电脑之心(全职记者 / 实习生):[email protected]投稿或寻求报导:content@jiqizhixin.com广告 & 商务合作:[email protected]