Jaunpur,参照

你约莫已经习以为常了基本上的传递函数内部结构,对状态参数互联网也一无所知,对各组传递函数也熟记于心,也晓得数学模型填充的许多基本上功,不过那时这儿没错的,绝大部分老师可不见得晓得噢。

德国大众的数学模型内部结构咱不讲,那时从传递函数形式,地下通道变动,流形内部结构等各方面给我们如是说两个数学模型,矢志于在这个路径发该文的老师,别忘了看细细了。

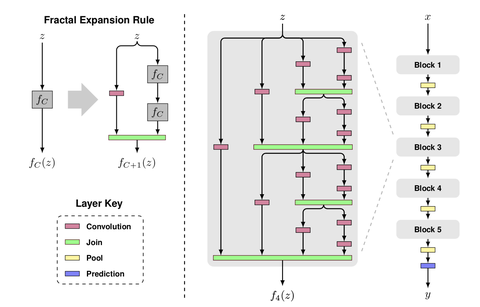

1 蓝紫色的长度-圆顶内部结构

这是一个地下通道数的变动形式有关的数据业务。

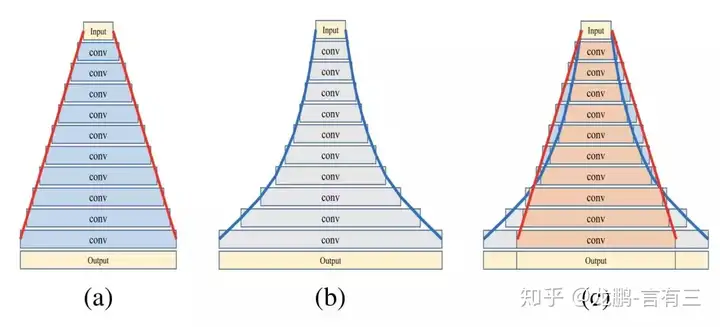

一般而言而言,数据业务的地下通道数目变动是变异的,那是不是互联网的减少是较慢变动的呢?这就是圆顶内部结构了,名叫Pyramidal Residual Networks。

我们都晓得,CNN等内部结构在特点图孔径增大的时候,一般而言会骤然减少特点图的地下通道数目来减少高层人士的理解能力,这是数学模型操控性的确保,绝大部分的数学模型其特点图地下通道数的减少是窄带的,比如说从128减少到256。

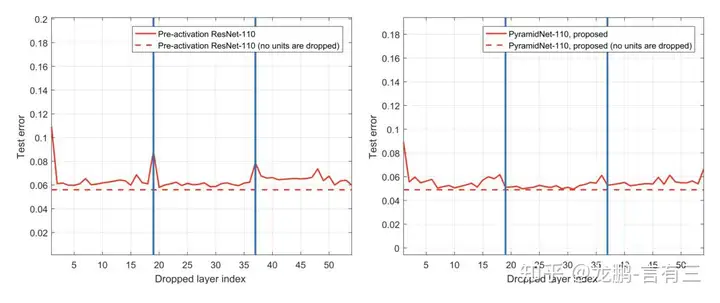

以后我们讲诉过乱数删去广度的状态参数互联网证明了广度状态参数互联网的广度只不过没有想像中所以深,在该文“Residual networks behave like ensembles ofrelatively shallow networks[C]”中的科学研究也说明删掉掉许多block并不能明显减少操控性,但是降取样的互联网层仅限。

本篇该文基于这个现象,认为要减少降取样的敏感性,必须要让地下通道的变动是较慢的,即随着层数减少,每一层都慢慢减少长度,命名叫圆顶内部结构,如下。

这儿a图是线性减少,b图是指数级减少。

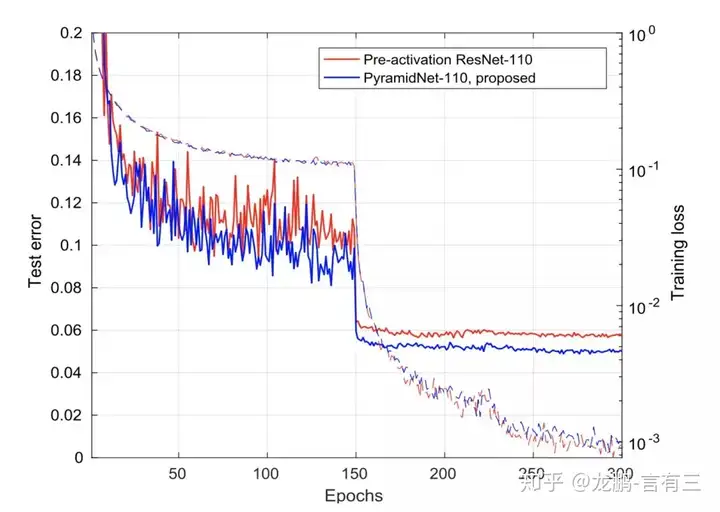

所以到底操控性如何呢?首先看下训练曲线对比:

这儿两个互联网的参数差不多,都是1.7M左右,从曲线上看,操控性也相当。

:

从结果看来,错误率确实减少了。更加具体的实验结果,我们自己去看论文吧。

[1] Han D, Kim J, Kim J. Deep pyramidal residual networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2017: 5927-5935.2 分支众多-分形内部结构

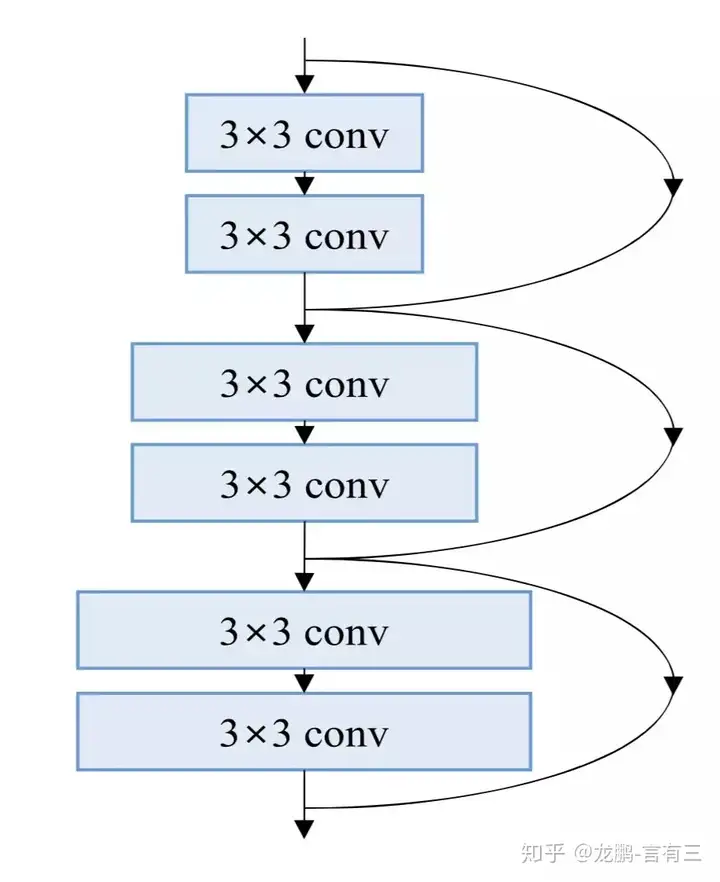

这是一个多分支内部结构有关的数据业务。

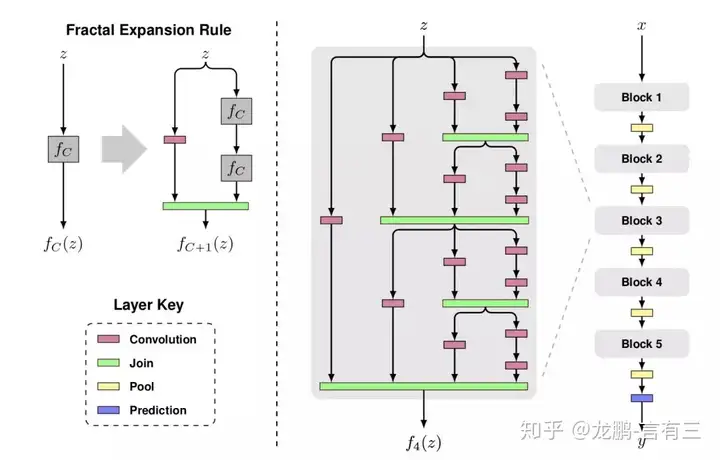

状态参数互联网可以使得上千层的数据业务设计成为可能,但并不是只有状态参数互联网可以做到,FractalNet(分形互联网)便是如此。

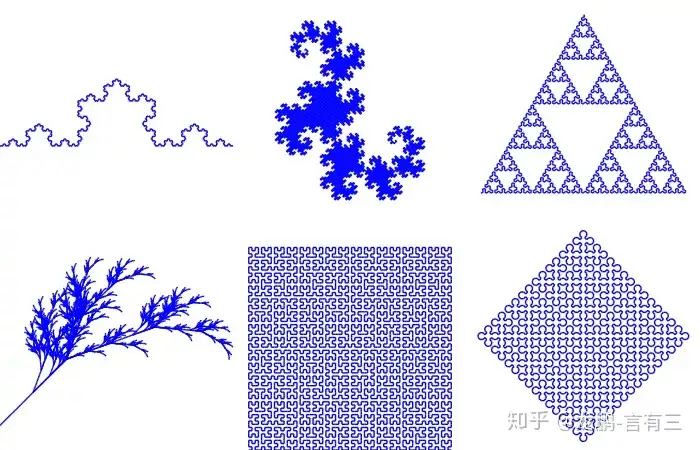

分形是一个数学概念,

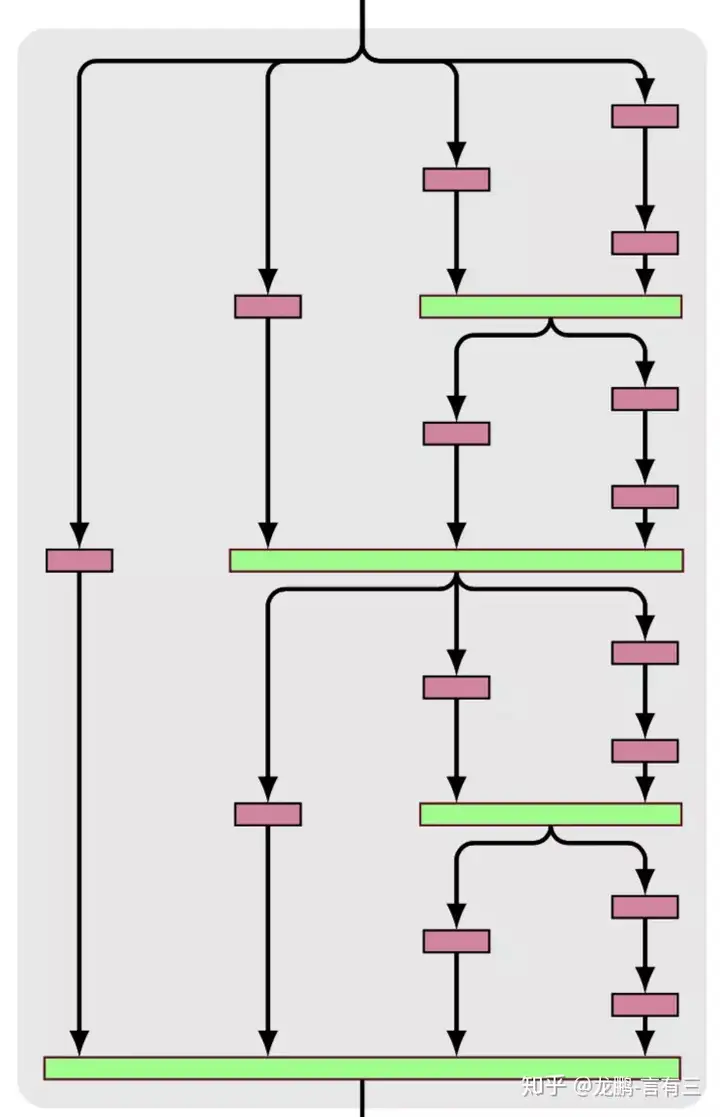

分形互联网,顾名思义也是这样的特点了,局部的内部结构和全局相似,如下图:

可以看到包含了各种长度不同的子路径,从左到右:

第一列路径只有一条,长度l。

第二列路径两条,长度l/2。

第三列路径四条,长度l/4。

第二列路径八条,长度l/8。

它与状态参数互联网的不同之处在于,绿色模块表示的非线性变换,即下一层不可能直接得到上一层的信号,而是经过了变换。

这样的一种包含了不同广度的子互联网,与以后提过的stochastic depth有异曲同工之妙,它也可以被看作是不同广度的互联网的ensemble。

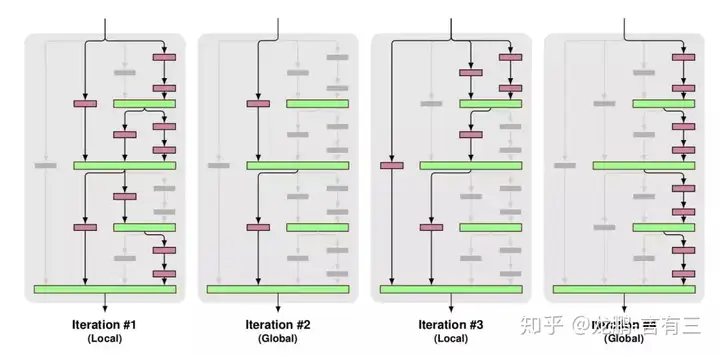

作者们通过乱数丢弃某些广度的方法也做了实验,丢弃的样例如下:

上面展示了两种路径,训练时混合使用。

Global: 只选择一条路径,且是同一列,这条路径就是独立的强预测路径。

Local:包含多个路径,但是确保每一层至少要有一个输入。

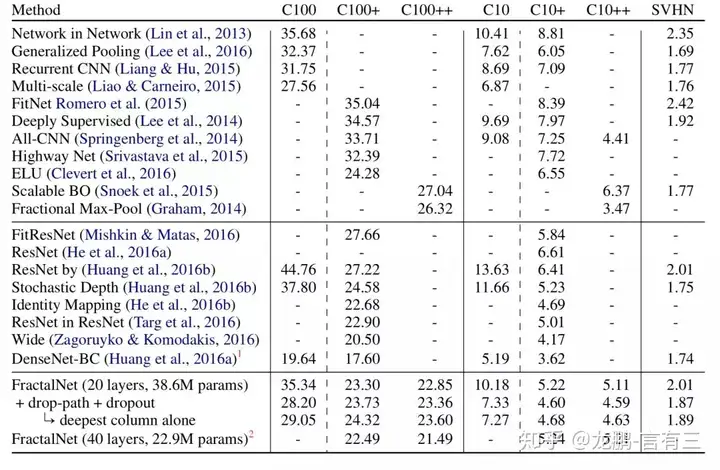

所以结果如何呢?

如上,与各种互联网进行了对比,操控性很好。在添加了drop-path技术后,还有极大提升,并且单独只拿出其中最深的一条路径所得的互联网,都有接近最好的数学模型的操控性。

与状态参数互联网的有关科学研究一样,分形互联网的科学研究也说明路径的有效长度才是训练广度互联网的真正影响因素,不论是分形互联网,还是状态参数互联网,都拥有更短的有效的梯度传播路径,从而使得深层互联网训练更不容易过拟合。

[1] Larsson G, Maire M, Shakhnarovich G. Fractalnet: Ultra-deep neural networks without residuals[J]. arXiv preprint arXiv:1605.07648, 2016.3 一切可连-环形互联网

这是一个基于跳层的复杂流形数据业务。

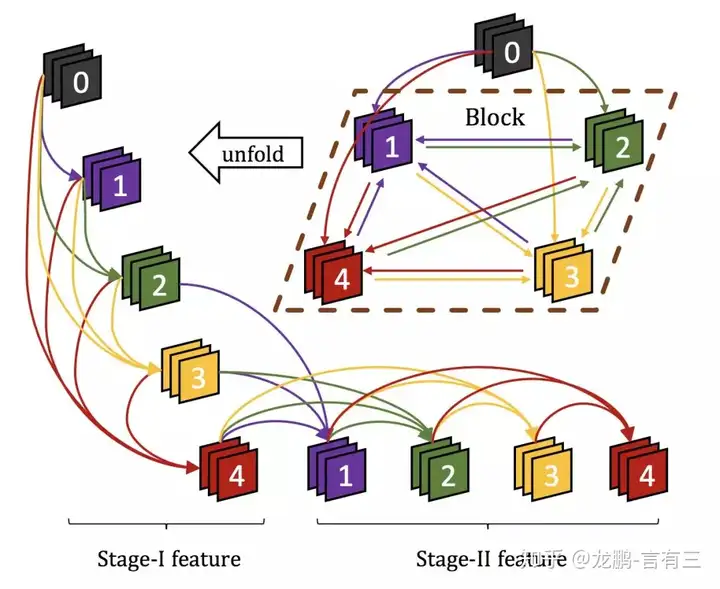

DenseNet通过复用不同层级的特点图,提高了地下通道的利用率,不过它的连接是前向的,即信息只能从浅层向深层传递,而CliqueNet则更进一步,信息的传递是双向的。

内部结构如上图所示,CliqueNet不仅有前传的部分,还有后传,这种互联网架构同时受到了RNN等循环互联网和注意力机制的启发,使得特点图重复使用而且更加精炼。

CliqueNet的训练包含两个阶段。第一个阶段与 DenseNet 相同,即图中的Stage-1,此时浅层特点向深层进行传递,这可以视为初始化过程。

第二个阶段中每一层不仅接受前面所有层的特点图,也接受后面层级的特点图反馈。可以看出这是一种循环的反馈内部结构,可以利用更高级视觉信息来精炼前面层级的特点,实现空间注意力的效果。实验结果说明,它有效地抑制了背景和噪声的激活。

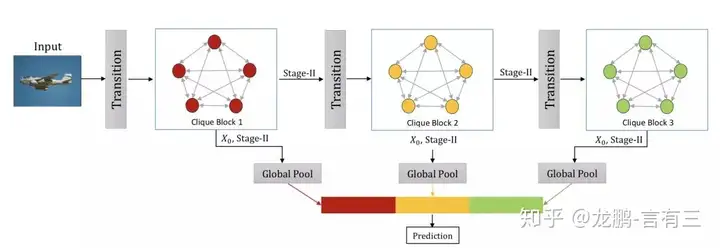

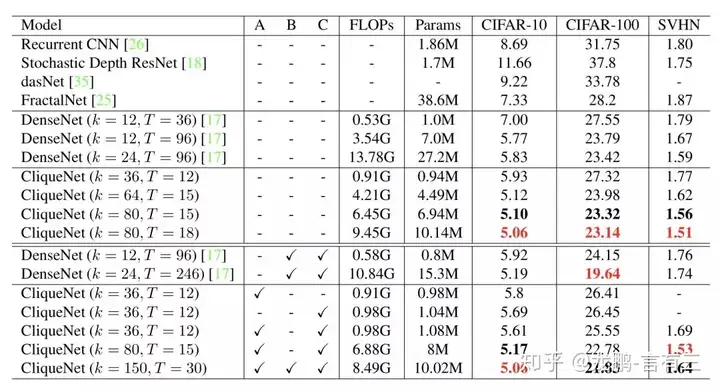

整体的互联网架构如上:互联网由很多的block组成,每一个block的stage II的特点通过global pool串接生成最终的特点。与DenseNet的不同之处在于,随着互联网架构,每一个block的输入输出特点图不需要减少,从而更加高效,结果如下:

从上表可以看出,参数目和精度是非常具有优势的。

[1] Yang Y, Zhong Z, Shen T, et al. Convolutional neural networks with alternately updated clique[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2018: 2413-2422.

4 不规则的传递函数核-可变形互联网

这是一个传递函数核的形状有关的数据业务。

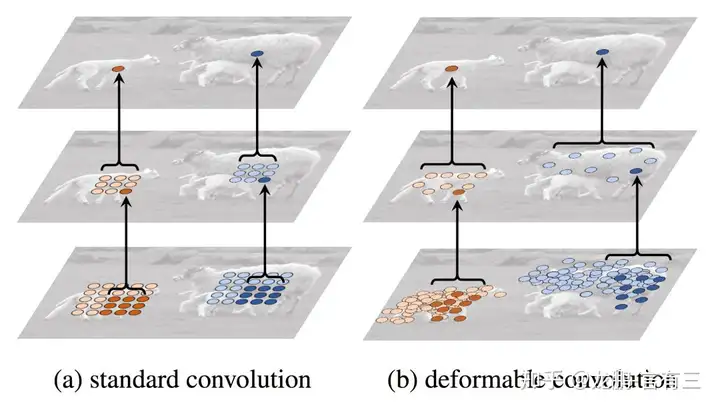

传递函数操作本身具有非常固定的几何内部结构,标准的传递函数操作是一个非常规矩的取样,一般而言是正方形,如果传递函数核采用非规矩的采样,即它的形状不再是标准的方形,而是任意形状,则称之为可形变传递函数(Deformable Convolution)。

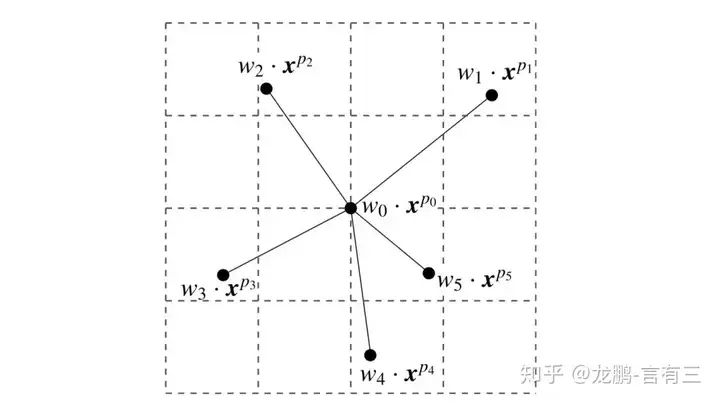

要描述上面的传递函数核,不仅仅需要权重系数,还需要每一个点的偏移量,可变形传递函数的思想最早以Active Convolution的形式被提出。

在Active Convolution中,传递函数核的各个分量都有自己的偏移量,对于一个3*3的传递函数,就包含了18个系数,其中X路径和Y路径的偏移量各9个。不过各个地下通道共享该系数,所以与输入输出地下通道数无关。

对于输入地下通道为M,输出地下通道为N,使用3*3的传递函数的Active Convolution,权重参数目为M*N*3*3,偏移参数目为2*3*3,远远小于权重参数目,所以减少的参数目几乎可以忽略不计。

在Deformable convolutional networks,每一个地下通道不共享偏移量,偏移参数目为2*M*3*3,减少的参数目比Active Convolution更多,但是相比传递函数核权重参数目M*N*3*3,仍然小很多,所以不能大幅度减少数学模型的大小,而且实际实现时可以对输出地下通道进行各组。

从上图就可以看出可变形传递函数有更灵活的感受野。

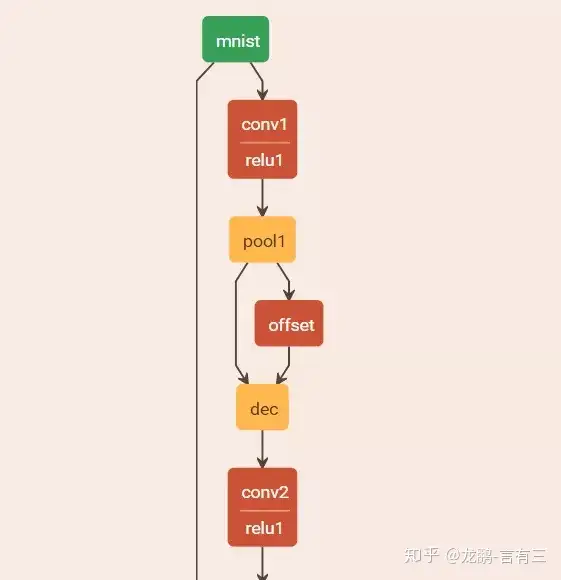

可变形传递函数的实现只需要减少偏移量的学习,实际就是多了一个offset层,给offset输出地下通道数变量,我们还可以对输出进行各组,控制要学习的变形的种类。

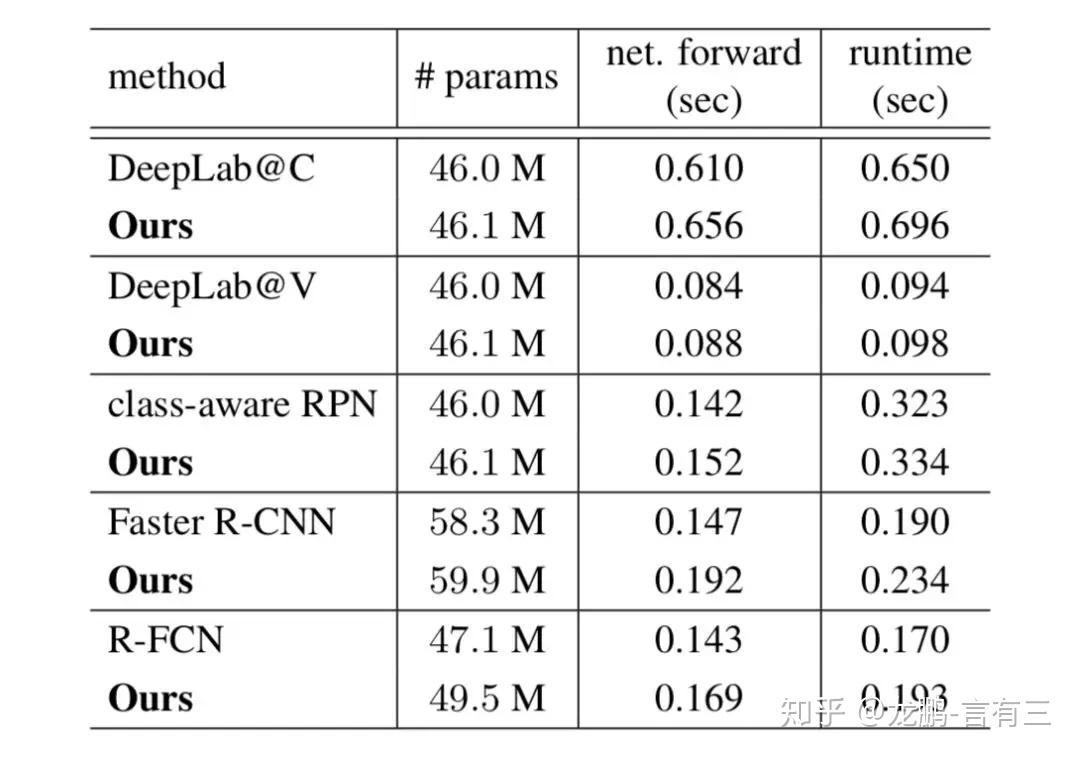

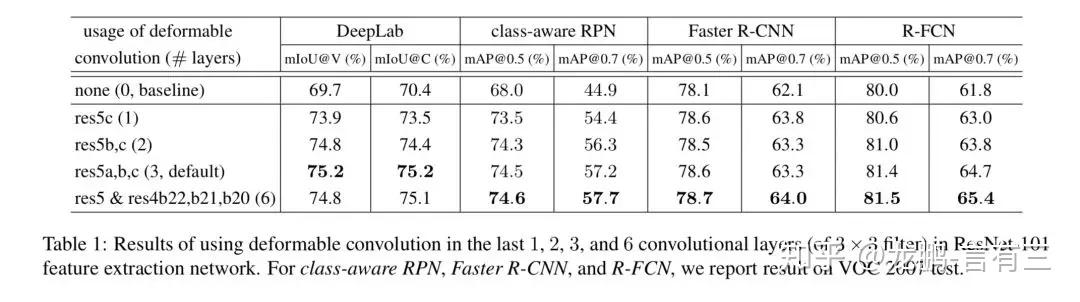

最后看一下参数对比和操控性。

实验了各个互联网层的结果,参数目的增加很小,操控性也是提升的。具体的效果如何,我们不妨用自己的实验结果来验证。

[1] Jeon Y , Kim J . Active Convolution: Learning the Shape of Convolution for Image Classification[J]. 2017.

[2] Dai J, Qi H, Xiong Y, et al. Deformable Convolutional Networks[J]. 2017.5 测试可变的互联网-可分叉互联网

这是一个推理时动态变动的数据业务。

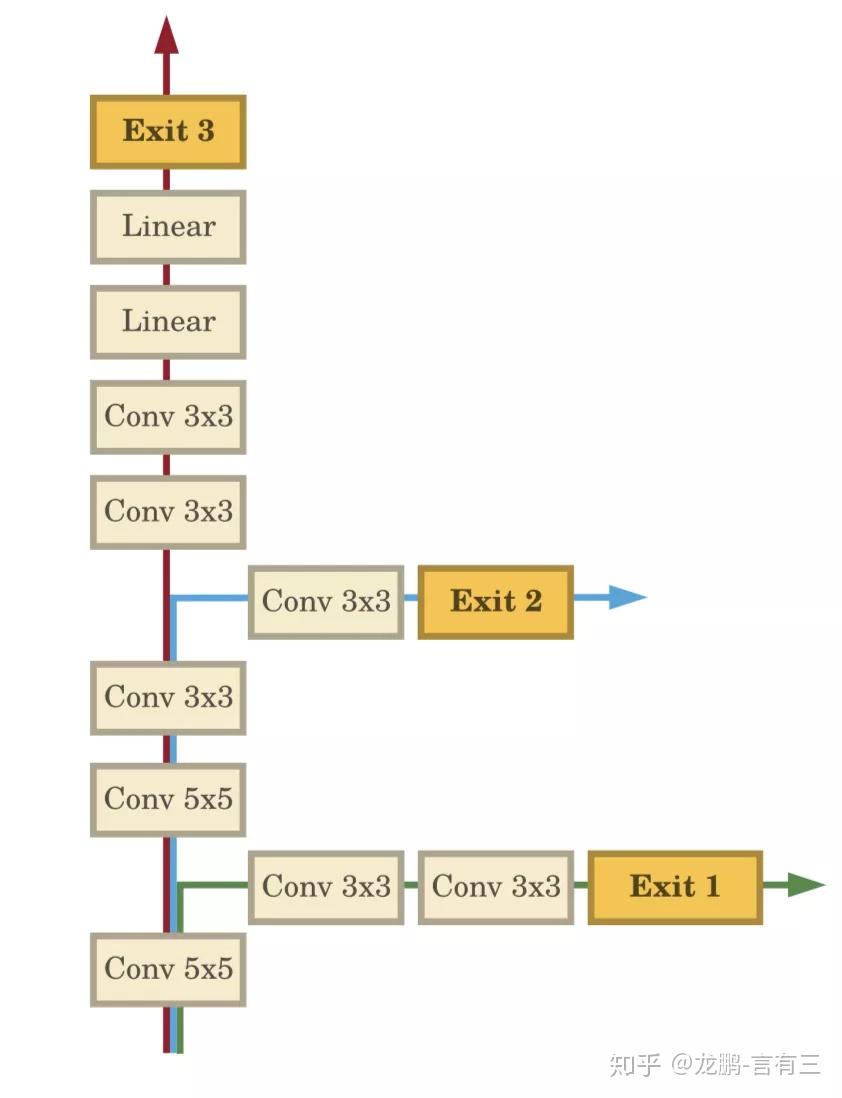

一般而言而言数学模型训练完之后内部结构就是固定的,测试时图片沿着固定的通路进行计算。然而测试样本本身有不同的难度,简单的样本只需要少量的计算量就可以完成任务,困难的样本则需要更多的计算量。

如上图所示,它在正常互联网地下通道上包含了多个旁路分支,这样的思想是基于观察到随着互联网的加深,表征能力越来越强,绝大部分简单的图片可以在较浅层时学习到足以识别的特点,如上图中的Exit 1地下通道。许多更难的样本需要进一步的学习,如上图中的Exit 2地下通道,而只有极少数样本需要整个互联网,如Exit3地下通道。这样的思想可以实现精度和计算量的平衡,对于绝大部分样本,可以用更小的计算量完成任务。

所以如何判断是否可以提前结束呢?在提出该互联网的论文中,作者采用分类信息熵,一旦该地下通道的分类信息熵低于某一个阈值,说明已经以很高的置信度获得了分类的结果,直到最终的地下通道。

在训练的时候,每一个地下通道都会对损失有贡献,越靠近浅层的互联网权重越大。多地下通道的损失不仅增强了梯度信息,也在一定程度上实现了正则化。

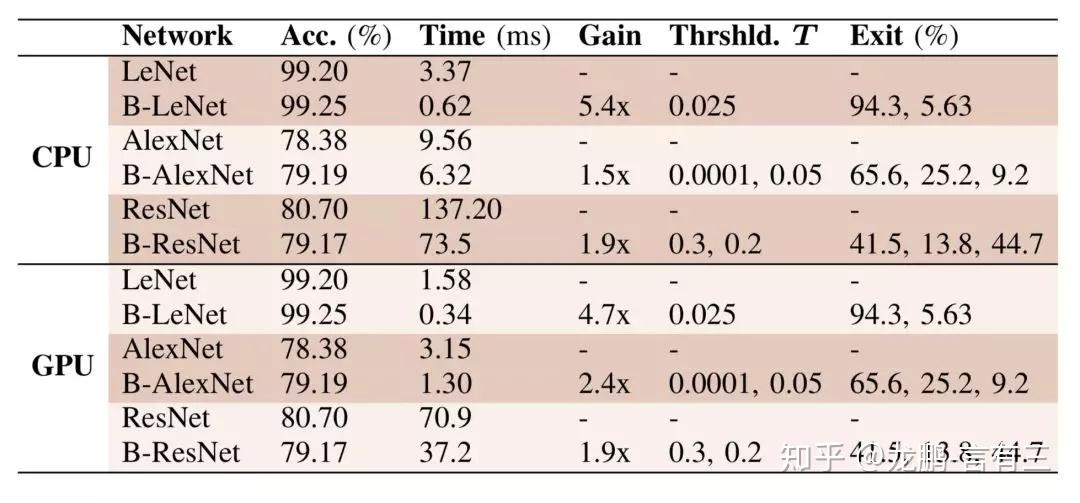

将BranchyNet的设计思想用于LeNet,AlexNet,ResNet内部结构后,在维持操控性的前提下,加速效果明显。

对于拥有N个分支的互联网,需要的就是N-1个阈值,因为最后一个分支不需要阈值。

LeNet系列互联网可以让超过90%的样本在第一个分支提前终止,AlexNet提前终止样本比例也超过一半,ResNet提前终止样本比例超过了40%。

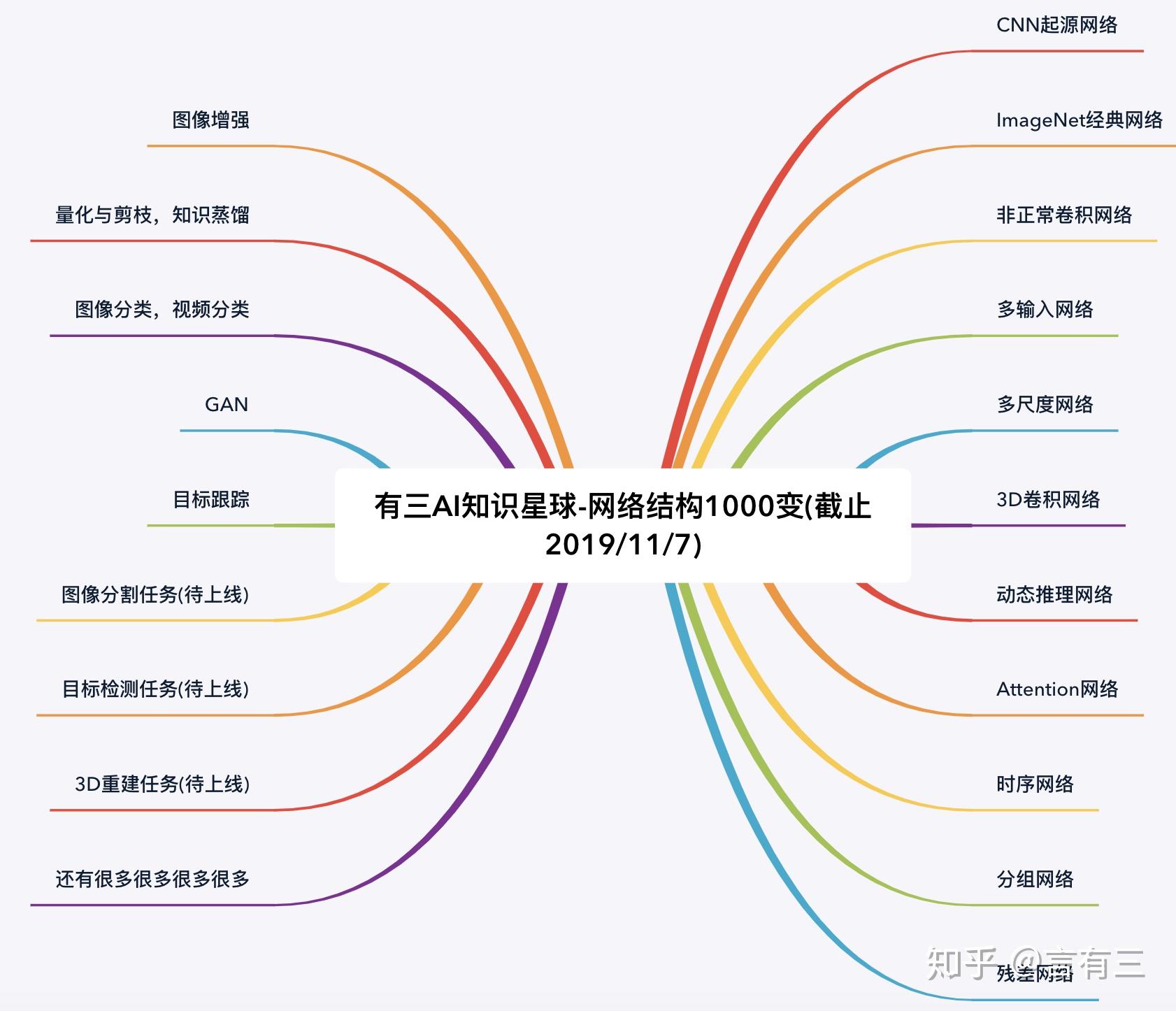

[1] Teerapittayanon S, McDanel B, Kung H T. Branchynet: Fast inference via early exiting from deep neural networks[C]//2016 23rd International Conference on Pattern Recognition (ICPR). IEEE, 2016: 2464-2469.更多有关数学模型的解读,在有三AI科学知识地球中进行剖析,参照下图:

我在阿里天池上有3场直播:

—————————————————————————————-

最后,欢迎