An. 征稿

比Meta的「拆分所有人数学模型」(SAM)更慢的影像拆分辅助工具,来了!

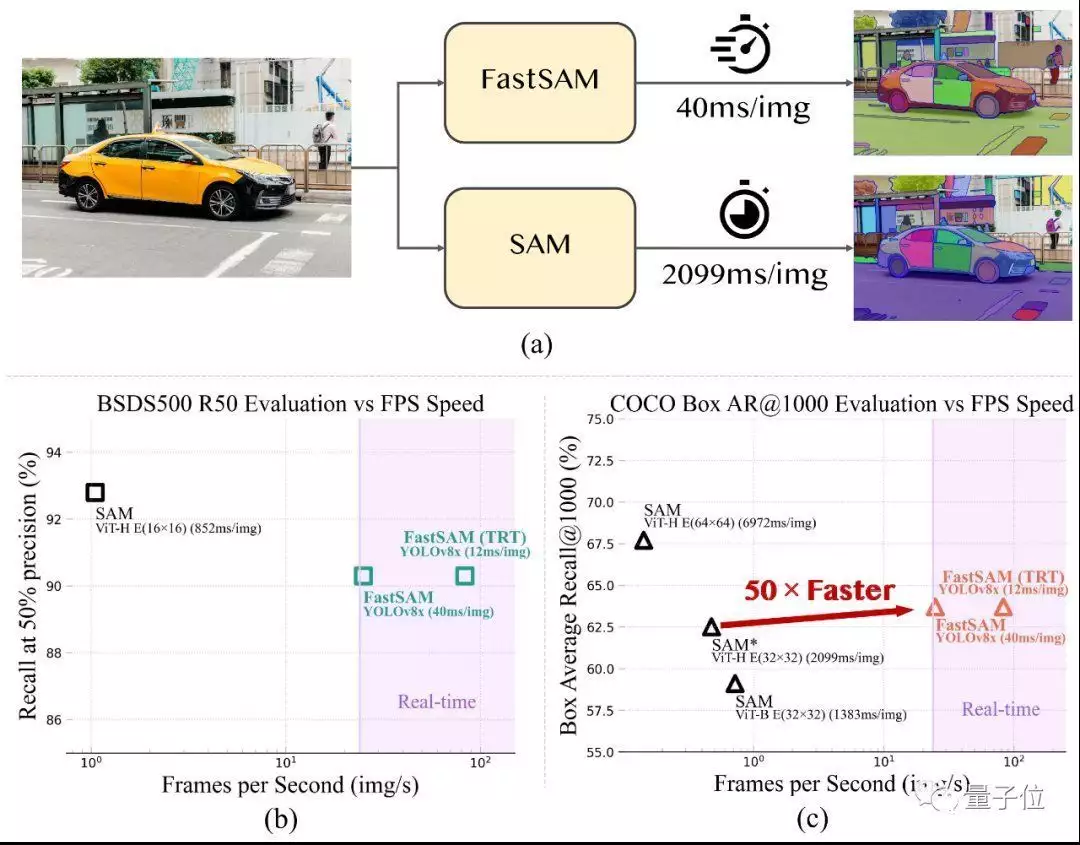

前段时间我国科学院项目组开放源码了FastSAM数学模型,更有吸引力50倍的速率达至与原初SAM相似的效用,并同时实现25FPS的动态逻辑推理。

有关学术论文预稿本也已刊登。

附注由征稿者提供更多

听觉此基础数学模型 SAM[1]在很多计算机系统听觉各项任务中产阶级⽣了重⼤负面影响。它早已正式成为影像拆分、影像叙述和影像编辑等各项任务的此基础。

然⽽,其巨⼤的随了妨碍了它在实际情景中的⼴泛应⽤。

前段时间,我国科学院⾃动化所明确提出并开放源码了⼀种快速代替⽅案 FastSAM。

透过将拆分⼀切各项任务再次分割为全示例拆分和提⽰辅导优先选择三个⼦各项任务,⽤带示例拆分分⽀的常规 CNN 检测器以⾼出50倍的运⾏速率同时实现了与SAM⽅法相当的性能,是⾸个动态拆分⼀切的此基础数学模型。

意义与动机

SAM 的出现带动了 “拆分⼀切”(Segment Anything)各项任务的发展。这⼀各项任务由于其泛化性和可扩展性,有很⼤可能正式成为未来⼴泛听觉各项任务的此基础。

FastSAM 为该各项任务提供更多了⼀套动态解决⽅案,进⼀步推动了拆分⼀切数学模型的前述应⽤和发展。

本⽂将“拆分⼀切”各项任务解耦为全示例拆分和提⽰引导优先选择两阶段,透过引⼊⼈⼯先验结构,在快速 50 倍的情况下同时实现了与 SAM 相似的表现。

FastSAM 的优秀表现为听觉各项任务的架构优先选择提供更多了新的视角——对于特定各项任务,专用数学模型结构或许在计算效率和精确度上仍具有优势。

从数学模型压缩的⾓度看,FastSAM 也证明了基于大数学模型产生高质量数据,透过引⼊⼈⼯先验结构大幅降低计算复杂度的路径的可⾏性。

示例

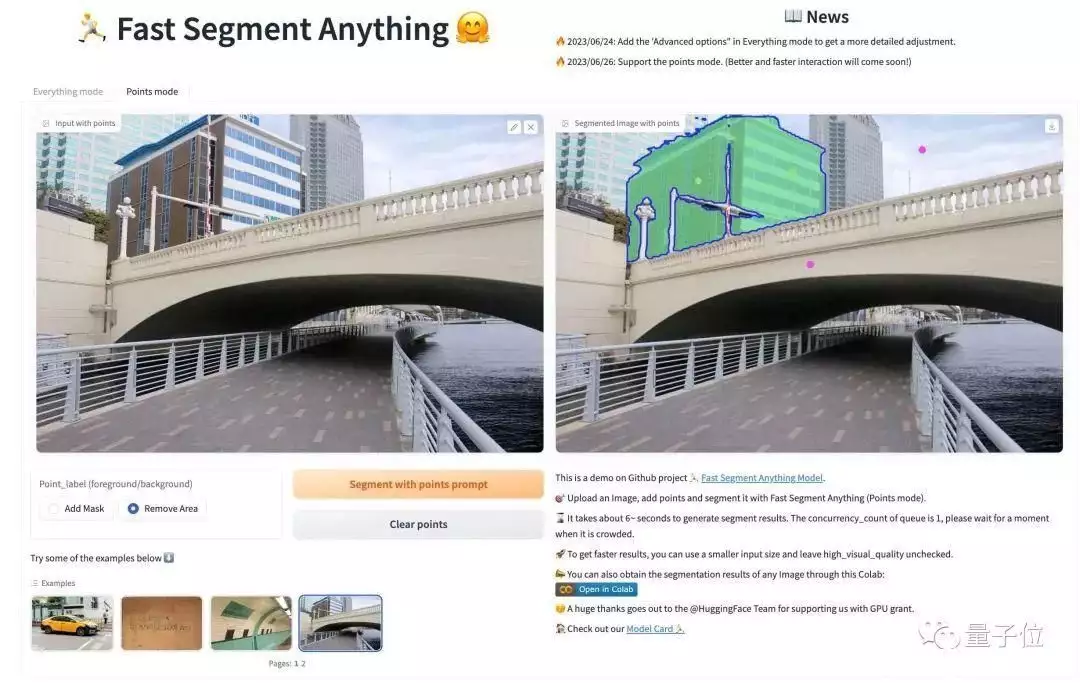

– Web DEMO

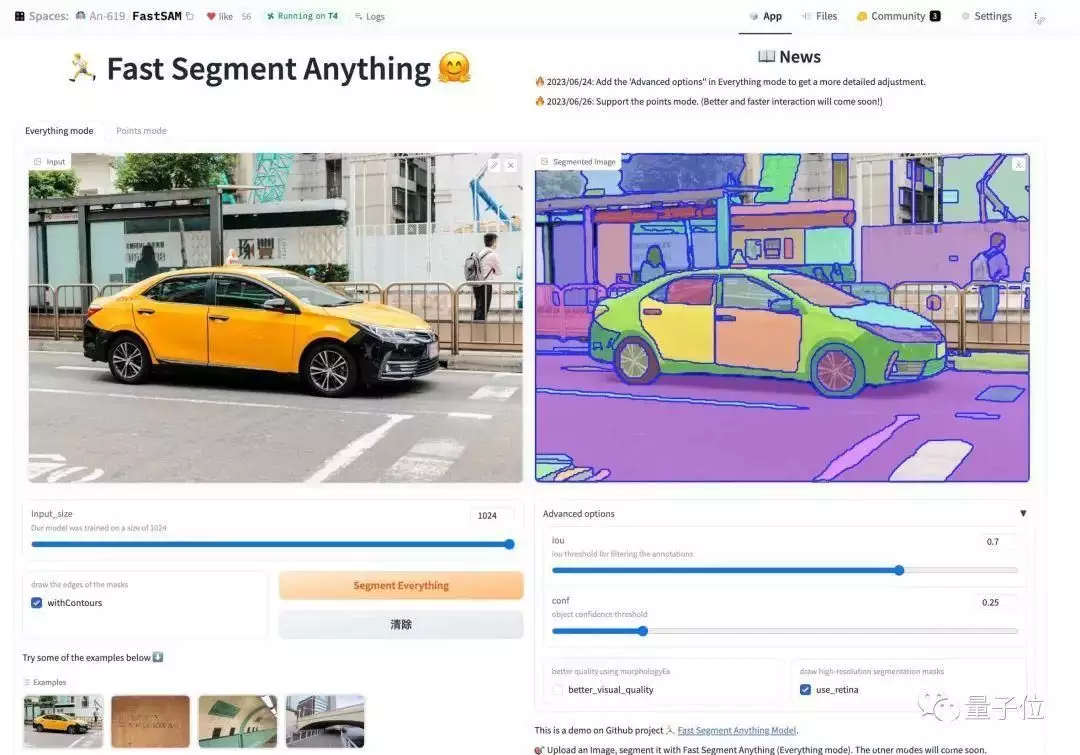

在 HuggingFace 的 Space 中,你可以快速体验 FastSAM 的拆分效用。

你可以上传一张自定义的图片,优先选择模式并设置参数,点击拆分按钮,就可以得到一个满意的拆分结果。

现在支持所有人模式和点模式的交互,其他模式将在未来尝试支持。在 Replicate 上已支持所有模式的在线体验。

– 多种交互⽅式

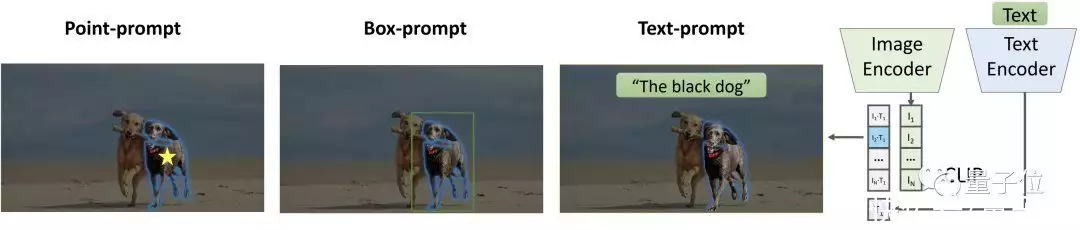

FastSAM目前共支持三种交互方式。

·多点交互模式

FastSAM ⽀持多个带有前景/背景标签的点交互模式,可以很好地适应不同情景的应⽤需求。

以缺陷检测情景为例,只需对缺陷部位添加前景点,对正常药丸部分添加背景点,即可准确地检测出物体缺陷。

·框交互模式

FastSAM 也⽀持框交互模式。也以缺陷检测为例,只需对缺陷⼤致位置进⾏框选,即可准确检测出物体缺陷。

·⽂本交互模式

FastSAM 也⽀持并开放源码了⽂本交互模式。透过不同的⽂本提示,FastSAM可以准确拆分出不同颜⾊的⼩狗。

工作原理

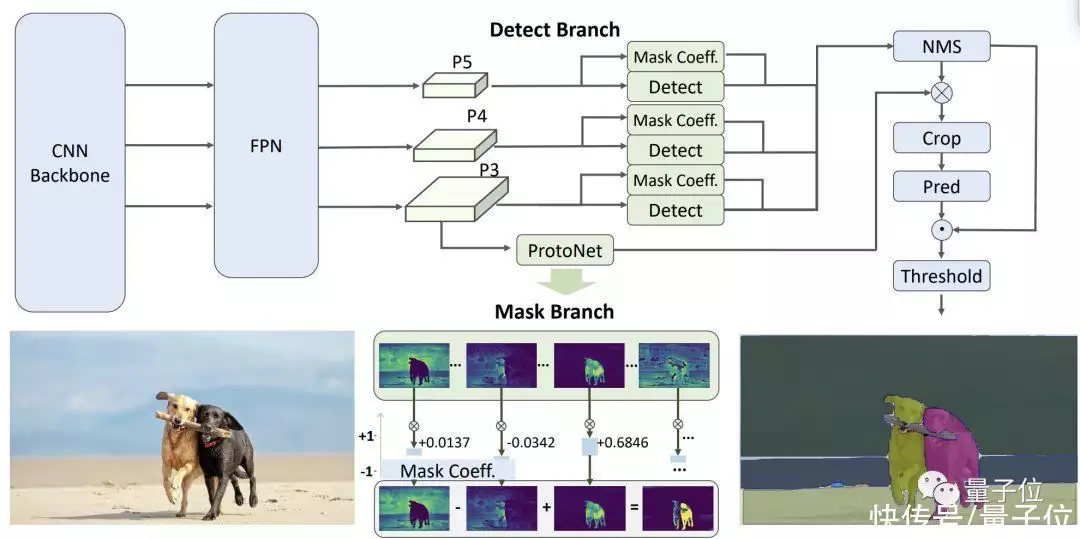

如下图所示,FastSAM 的网络架构可分为三个阶段:全示例拆分和提示引导优先选择。

在全示例拆分阶段,FastSAM 使用卷积神经网络来对影像中的所有对象或区域进行分割。

在提示引导优先选择阶段,它采用包括点提示、框提示和文本提

与基于Transformer的方法不同,FastSAM融合了与听觉拆分各项任务紧密有关的先验知识,例如局部连接和对象分配策略。这使得它以更低地参数量和计算量下更慢地收敛。

定性与定量分析

测试结果表明,FastSAM各方面的表现完全不输于Meta的原初版本。

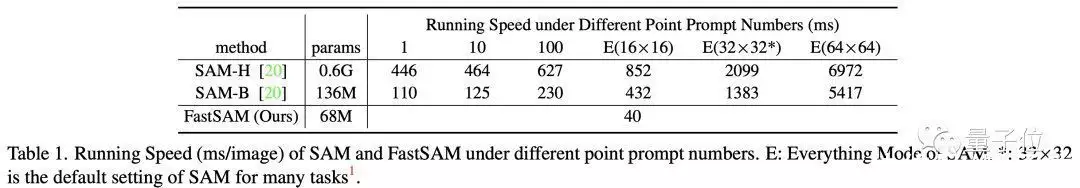

·速率

从表中可以看出,FastSAM 取得了远超 SAM 的速率表现,在「拆分⼀切」模式下,SAM的速率会受到均匀点提⽰数量的负面影响,⽽ FastSAM 由于结构的特点,运⾏时间不随点提⽰数量的增加⽽增加,这使得它正式成为「拆分⼀切」模式的更好优先选择。

同时,由于 FastSAM 在结构设计中利⽤了⼈的先验知识,使得它在动态逻辑推理的同时也具备了与 SAM 相当的性能。

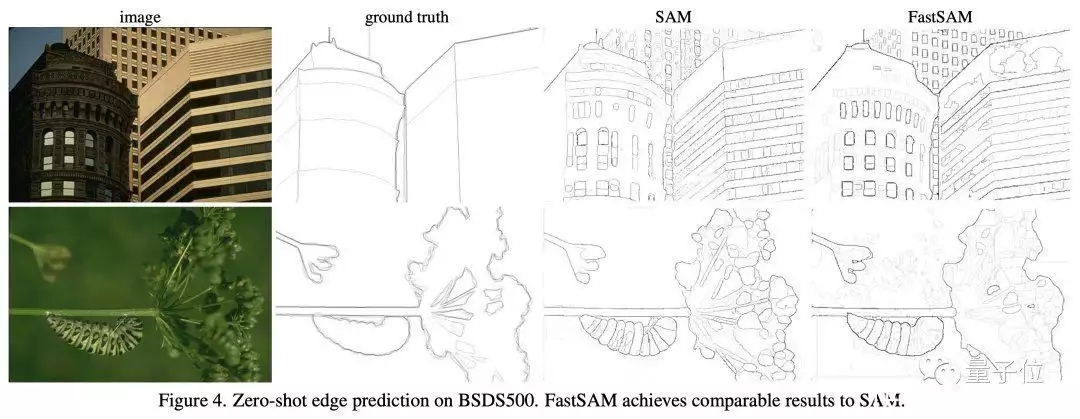

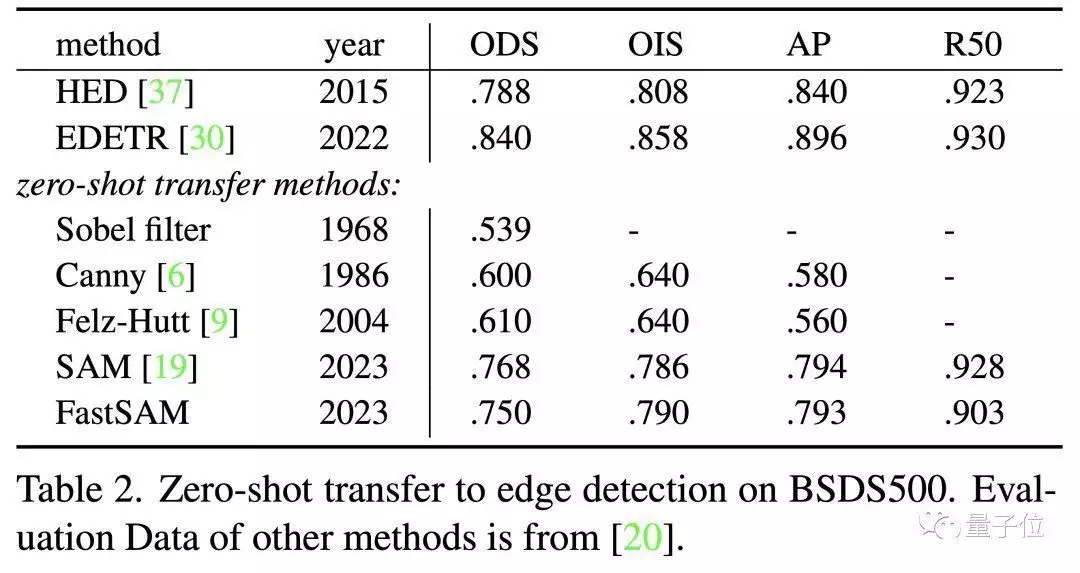

·边缘检测

下图展⽰了具有代表性的边缘检测结果。经过定性检视可以看出,尽管FastSAM的参数明显较少(只有68M),但它也能产⽣很⾼质量的边缘检测结果。

从下表可以看出,FastSAM 取得了与 SAM 类似的性能。与 Ground Truth 相⽐,FastSAM和 SAM 都倾向于预测更多的边缘,这种偏差在表中得到了定量的反映。

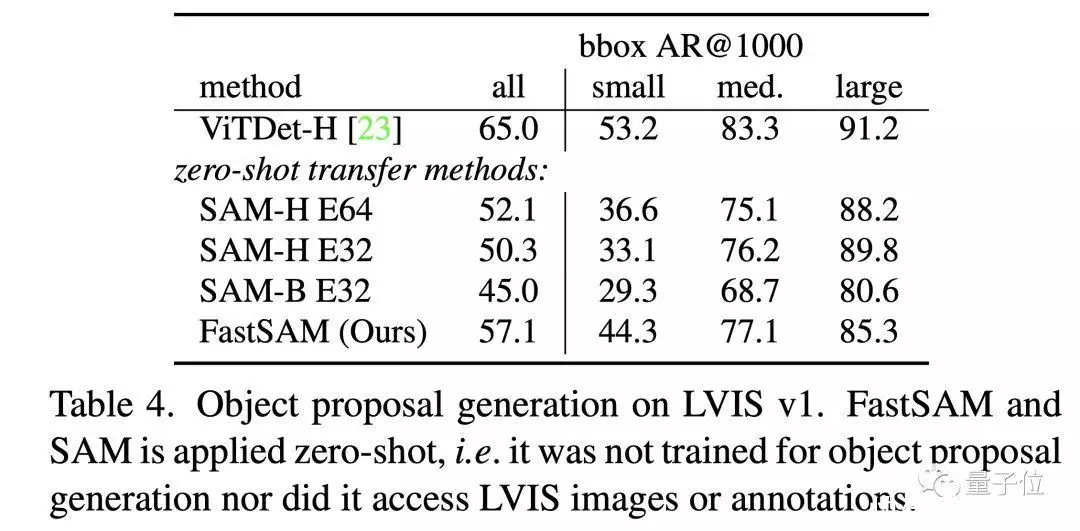

·物体候选

从下表可以看出,FastSAM 在 bbox AR@1000 的表现上超过了计算量最⼤的 SAM 数学模型(SAM-H E64),仅次于在 LVIS 数据集上监督训练的 ViTDet-H[2]。

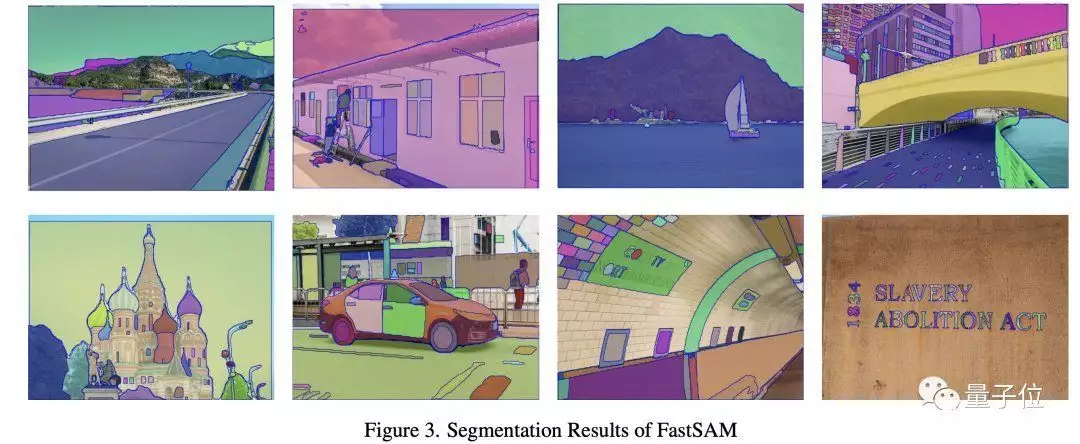

·可视化结果

SA-1B 拆分结果:下图展⽰了 FastSAM 在 SA-1B 数据集上不同情景和掩码数量时的拆分结果。

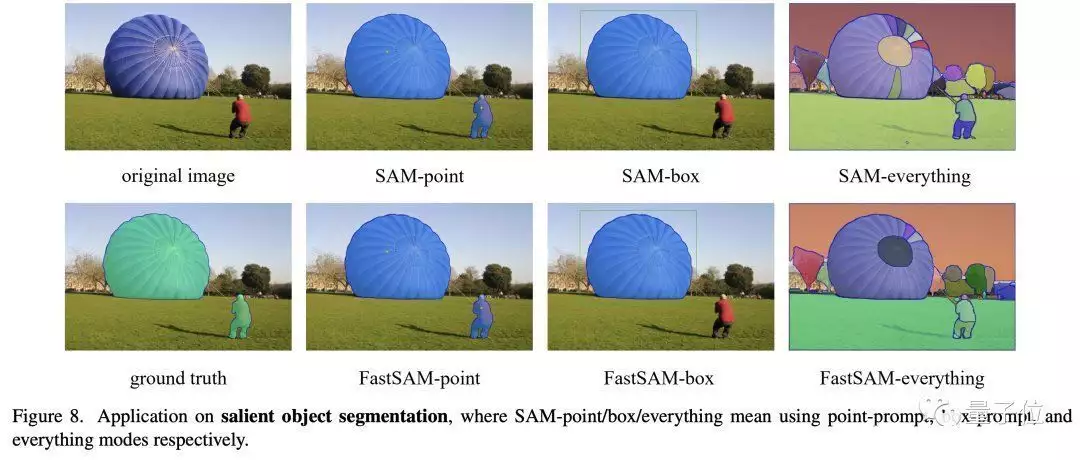

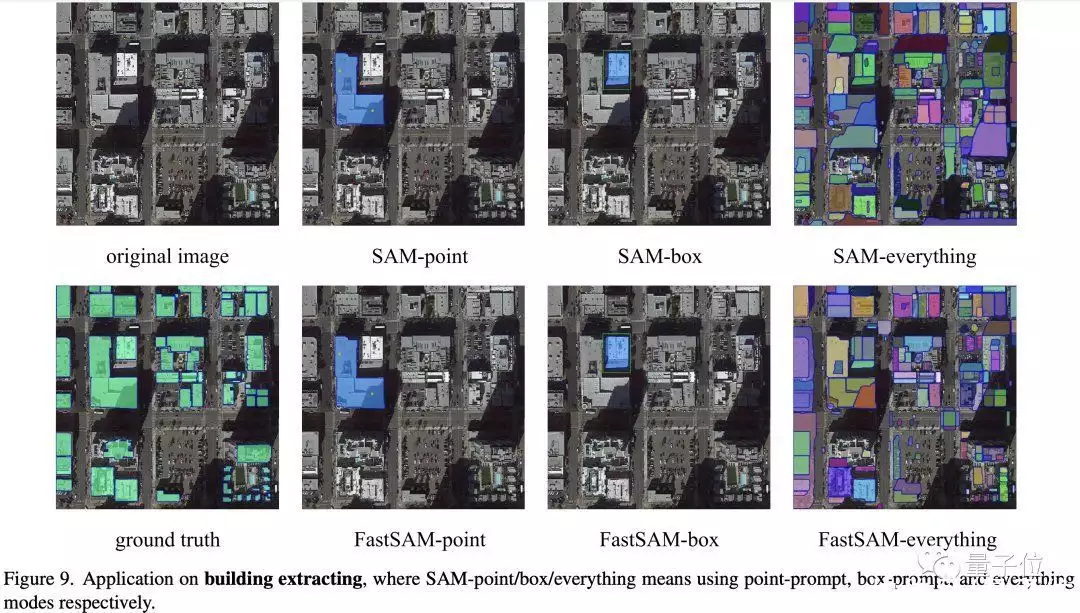

下游应⽤对⽐:下⾯三张图对⽐了 FastSAM 和 SAM 在异常检测、显著物体拆分和建筑物提取三个下游各项任务的效用,FastSAM 在不同模式下均取得了和 SAM 相当的表现。

参考⽂献

[1] Kirillov A, Mintun E, Ravi N, et al. Segment anything[J]. arXiv preprint arXiv:2304.02643, 2023.[2] Li J, Yang T, Ji W, et al. Exploring denoised cross-video contrast for weakly-supervised temporal action localization[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2022: 19914-19924.学术论文地址:

https://arxiv.org/abs/2306.12156GitHub项目页:

https://github.com/CASIA-IVA-Lab/FastSAMHuggingFace DEMO:

https://huggingface.co/spaces/An-619/FastSAMReplicate demo:

https://replicate.com/casia-iva-lab/fastsam— 完 —

量子位 QbitAI · 头条号签约